MySQL数据库: 高并发电商场景下的架构设计与优化

1人参与 • 2025-10-25 • Mysql

原始数据库架构概述

如果企业使用典型的主从复制(master-slave replication)模式,整体结构相对简单且常见于多数中小型互联网企业

整个数据库集群由一组共十五台 mysql 服务器构成,其中仅存在一个 master 节点,其余十四台为 slave 节点,形成单一主节点向多从节点同步数据的架构。该架构在双十一大促前被广泛使用,如图所示(可理解为标准的一主多从拓扑),主节点负责处理全部写操作,并将变更日志(binlog)异步同步至各从节点,从节点主要用于读负载分担和灾备

此架构简洁且常见,广泛应用于中小型或初期发展阶段的企业系统中。然而,在面对极端高并发场景时,其固有缺陷逐渐暴露

此架构设计并未引入任何自动化的高可用组件,例如 mha(master high availability) 或基于 paxos/raft 协议的选主机制,导致系统在主库故障时无法实现自动切换

需特别指出:当前描述的并非最新架构,而是大促前的历史状态,后续经过dba与开发团队联合优化调整,具体改进方案将在后文详述

主从架构存在的核心问题

1 ) 缺乏高可用性:主库单点故障风险极高

该集群中仅存在一个主节点,且未部署任何自动化的主从切换组件(如 mha、mgr、orchestrator 或基于 raft 的高可用方案)。一旦主节点发生宕机或网络隔离,无法实现自动故障转移(failover),必须由 dba 手动介入处理:

- 从众多 slave 中挑选出数据最新、延迟最小的一台;

- 将其手动提升为新的 master;

- 配置其余 slave 指向新 master 进行复制;

该过程平均耗时约 30 分钟,期间写操作完全中断,严重影响线上交易、订单创建等关键业务流程

在 mysql 复制中,判断“数据最新”的标准通常依赖于 seconds_behind_master、relay_log_pos 以及 gtid executed set 的比对。若未启用 gtid,则需结合 binlog position(file + position)进行精确比对。

2 ) 网络带宽压力巨大,易引发连锁故障

所有 slave 均通过网络拉取 master 的 binlog 日志流,形成“一对多”的日志广播模式进行异步复制,在大促高峰期间,尤其当 qps 和 tps 达到峰值时,master 节点的网卡承受极大负载,主库网络吞吐接近饱和,成为潜在的性能瓶颈和故障源头,表现为复制延迟陡增、客户端响应变慢甚至超时。事实上,尤其在促销活动开始瞬间,流量洪峰叠加日志同步需求,加剧了主节点的网络负荷,在后续运维过程中,确实因网卡过载引发过多次通信异常。

该服务器硬件配置强劲:64核cpu、512gb内存,并经过深度优化(包括参数调优、索引优化、查询重写等),因此具备支撑如此高吞吐的能力

监控数据显示:

- qps 最高突破 35万次/秒;

- tps 接近 10万次/秒;

- 并发请求数超过 700;

- cpu 使用率接近 100%(空闲率 idr 接近 0);

这表明数据库已处于极限运行状态,而此时所有 slave 对主库的复制流量进一步加剧了网络拥塞,最终曾导致因网卡饱和引发的服务降级甚至短暂不可用。

此处 qps 指每秒执行的 sql 查询总数,包含 select、insert、update、delete;tps 特指事务级别操作频率

另一组关键监控显示:

- 数据库在同一时间处理的并发请求数(active connections processing)最高达700以上。

- 对应的cpu使用率长时间维持在接近100%,表明计算资源已被完全榨干。

- 特别说明:监控中的“idle”指标表示cpu空闲百分比,例如90% idle 意味着cpu仅有10%处于工作状态。若idle接近0,则说明系统处于极度繁忙状态

相关术语

- qps(queries per second):每秒查询次数,包含 select、show 等读操作

- tps(transactions per second):每秒事务数,反映写入能力

- idr(idle rate):cpu 空闲百分比,值越高代表负载越低

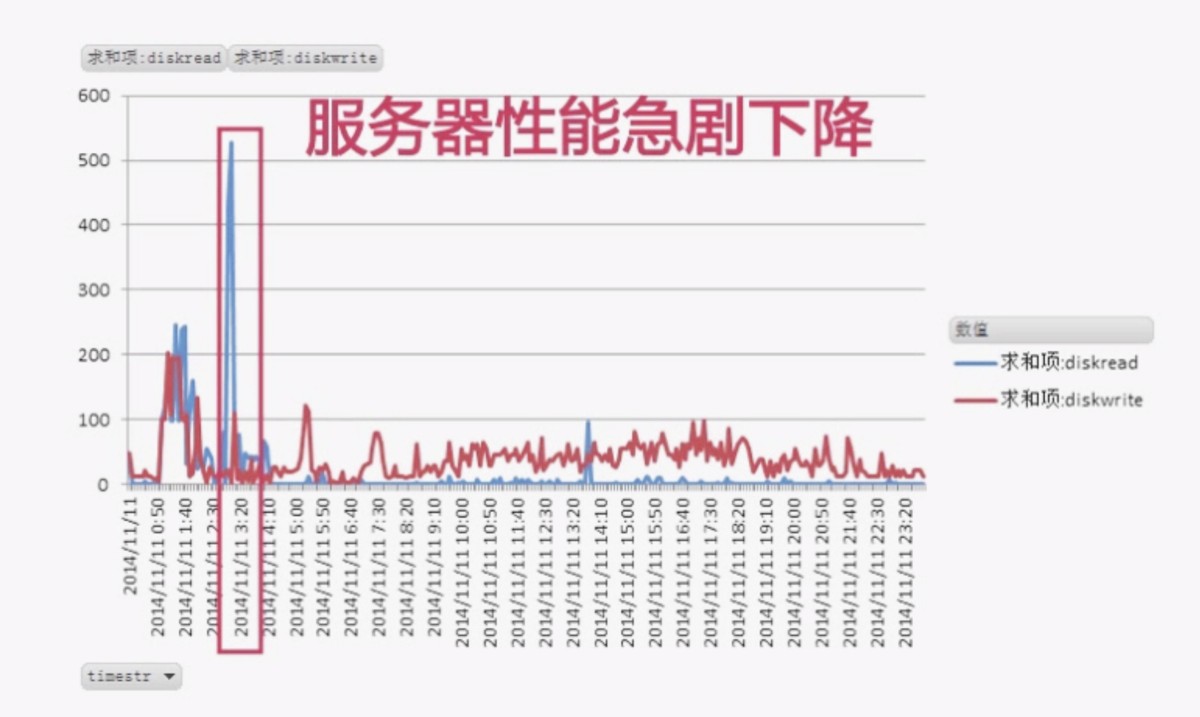

磁盘 io 异常分析与备份任务优化

监控显示,在凌晨 2:30 左右出现一次明显的磁盘 io 高峰,引发团队警觉。经排查发现,该峰值源于一项定时执行的 数据库远程备份同步任务 —— 即通过 mysqldump 或物理备份工具将主库数据拷贝至异地存储节点

该服务器配备的是高性能 nvme ssd 设备,具备较高的iops和吞吐能力,支持高qps/tps的基础存储性能。

此举严重违背了高并发系统的最佳实践:

绝不应在主库上执行重量级备份任务!

主节点承担写 + 日志广播双重职责 → 网络出口带宽饱和

异步复制机制下,从节点越多,主节点压力越大

教训总结:

- 严禁在生产主库上执行备份、报表生成等重io任务

- 尤其是在大促保障期间,应将此类操作迁移至专用备库或离线环境

在大促期间,主库本就承载极高负载,额外的 io 开销极易造成:

- 查询响应变慢

- 事务堆积

- 复制延迟激增(replication lag)

- 进而触发雪崩式服务崩溃

然而,此次突发读操作引发团队警觉,因其可能导致:

- io争抢 → 查询延迟上升

- 缓冲池污染 → 热数据被挤出

- 复制线程阻塞 → 从节点延迟加大

经紧急排查,确认该峰值源于一项定时任务:数据库全量备份并通过远程rsync同步至异地机房。该操作直接在主库执行,导致大量冷数据扫描,触发随机读风暴。

教训总结:

- 严禁在主库执行全量备份、大数据导出等重io任务

- 此类操作应迁移至专用备份从库或离线环境

- 大促前必须关闭一切非必要计划任务

解决方案建议:

- 应将备份任务迁移至延迟可控的 slave 节点

- 或使用 lvm 快照、xtrabackup 等不影响服务的热备方案

基于 nestjs 的数据库连接管理与并发控制实现

为应对上述架构问题,在应用层需强化数据库访问的稳定性与容错能力

以下提供一套基于 nestjs + typeorm + mysql 的完整代码实现,涵盖连接池配置、异常重试、读写分离及分布式锁支持

1 )方案1

数据库模块配置(typeorm + 连接池优化)

// app.module.ts

import { module } from '@nestjs/common';

import { typeormmodule } from '@nestjs/typeorm';

import { configmodule, configservice } from '@nestjs/config';

@module({

imports: [

typeormmodule.forrootasync({

imports: [configmodule],

usefactory: (config: configservice) => ({

type: 'mysql',

host: config.get('db_host'),

port: config.get('db_port'),

username: config.get('db_user'),

password: config.get('db_pass'),

database: config.get('db_name'),

entities: [__dirname + '//*.entity{.ts,.js}'],

synchronize: false,

logging: ['error'], // 避免日志影响性能

extra: {

connectionlimit: 100,

queuelimit: 10,

connecttimeout: 10000,

acquiretimeout: 15000,

timeout: 10000,

},

replication: {

master: {

host: config.get('db_master_host'),

port: config.get('db_master_port'),

username: config.get('db_master_user'),

password: config.get('db_master_pass'),

},

slaves: [

{ host: 'slave1.example.com', port: 3306 },

{ host: 'slave2.example.com', port: 3306 },

// ... 其他 slave

],

},

}),

inject: [configservice],

}),

],

})

export class appmodule {}

支持读写分离:写请求走 master,读请求轮询 slaves

设置合理连接池上限防止资源耗尽

分布式锁实现(redis + lua 脚本,防超卖场景)

针对订单创建、库存扣减等高并发写场景,采用 redis 实现 分布式锁,避免竞态条件。

// redis-lock.service.ts

import { injectable } from '@nestjs/common';

import { redis } from 'ioredis';

@injectable()

export class redislockservice {

private readonly lock_script = `

return redis.call('set', keys[1], argv[1], 'nx', 'px', argv[2])

`;

private readonly unlock_script = `

if redis.call("get",keys[1]) == argv[1] then

return redis.call("del",keys[1])

else

return 0

end

`;

constructor(private readonly redis: redis) {}

async acquirelock(

key: string,

requestid: string,

expirems: number,

): promise<boolean> {

const result = await this.redis.eval(

this.lock_script,

1,

key,

requestid,

expirems,

);

return result === 'ok';

}

async releaselock(key: string, requestid: string): promise<boolean> {

const result = await this.redis.eval(this.unlock_script, 1, key, requestid);

return result === 1;

}

}

使用 lua 脚本保证原子性

requestid 防止误删其他服务持有的锁

乐观锁机制(适用于库存更新)

在商品库存表中添加版本号字段 version,利用 cas 原理实现无锁并发控制。

alter table product add column version int default 0; update product set stock = stock - 1, version = version + 1 where id = ? and version = ?

// product.service.ts

@injectable()

export class productservice {

@injectrepository(product)

private repo: repository<product>;

async decreasestock(productid: number, expectedversion: number): promise<boolean> {

const result = await this.repo

.createquerybuilder()

.update(product)

.set({ stock: () => 'stock - 1', version: () => 'version + 1' })

.where('id = :id and version = :version', { id: productid, version: expectedversion })

.execute();

return result.affected > 0;

}

}

适用于冲突较少场景

若失败需配合重试机制(指数退避)

消息队列削峰填谷(rabbitmq 示例)

为缓解数据库瞬时压力,在大促期间将非核心操作异步化处理

// order.processor.ts

@processor('order_queue')

export class orderprocessor {

@process('create_order')

async handleordercreation(job: job) {

const { orderid, userid, items } = job.data;

try {

await this.orderservice.createorder(orderid, userid, items);

return { success: true };

} catch (err) {

await job.movetofailed({ message: err.message }, true);

throw err;

}

}

}

生产者发送消息:

await this.queue.add('create_order', { orderid, userid, items }, {

attempts: 3,

backoff: { type: 'exponential', delay: 1000 },

});

利用 mq 实现流量削峰

失败自动重试 + 死信队列保障最终一致性

2 )方案2

乐观锁控制库存扣减(适用于轻度并发)

// inventory.service.ts

@injectable()

export class inventoryservice {

constructor(@injectrepository(product) private productrepo: repository<product>) {}

async deductstockoptimistic(productid: string, quantity: number): promise<boolean> {

const queryrunner = this.productrepo.manager.connection.createqueryrunner();

await queryrunner.starttransaction();

try {

const product = await queryrunner.manager.findone(product, {

where: { id: productid },

lock: { mode: 'pessimistic_read' }, // 可选:加悲观读锁防止脏读

});

if (!product || product.stock < quantity) {

throw new error('insufficient stock');

}

const affected = await queryrunner.manager.update(

product,

{ id: productid, stock: morethanorequal(quantity), version: product.version },

{ stock: () => `stock - ${quantity}`, version: () => `version + 1` }

);

if (affected.affected === 0) {

throw new error('concurrent update detected');

}

await queryrunner.committransaction();

return true;

} catch (err) {

await queryrunner.rollbacktransaction();

throw err;

} finally {

await queryrunner.release();

}

}

}

说明:通过version字段实现乐观锁,sql中使用条件更新避免aba问题

redis 悲观锁 + lua脚本原子扣减(中高并发推荐)

// redis.inventory.service.ts

@injectable()

export class redisinventoryservice {

private readonly stock_key = (id: string) => `inventory:${id}`;

constructor(private readonly redisservice: redisservice) {}

async deductwithpessimisticlock(

productid: string,

quantity: number,

ttlms = 5000

): promise<boolean> {

const lockkey = `lock:inventory:${productid}`;

const client = this.redisservice.getclient();

// 获取分布式锁(setnx + expire)

const acquired = await client.set(lockkey, '1', 'px', ttlms, 'nx');

if (!acquired) {

throw new error('failed to acquire inventory lock');

}

try {

const stockscript = `

local current = tonumber(redis.call('get', keys[1]))

if not current or current < tonumber(argv[1]) then

return 0

end

redis.call('incrbyfloat', keys[1], -argv[1])

return 1

`;

const result = await client.eval(

stockscript,

1,

this.stock_key(productid),

quantity

);

return result === 1;

} finally {

// 释放锁

await client.del(lockkey);

}

}

}

注意:实际生产环境中建议使用redlock算法或多节点redis cluster保障锁的可靠性

基于消息队列的最终一致性库存扣减(超高并发场景)

// order.processor.ts

@processor('order_queue')

export class orderprocessor {

constructor(

private readonly inventoryservice: inventoryservice,

private readonly eventpublisher: eventpublisher

) {}

@process('create_order')

async handleordercreation(job: job<orderpayload>): promise<void> {

const { orderid, productid, quantity } = job.data;

try {

const success = await this.inventoryservice.deductstockoptimistic(productid, quantity);

if (success) {

await this.eventpublisher.emitasync(new ordercreatedevent(orderid));

} else {

await this.eventpublisher.emitasync(new orderfailedevent(orderid, 'out of stock'));

}

} catch (error) {

// 失败重试机制

if (job.attemptsmade < 3) {

throw error; // 触发重试

} else {

await this.eventpublisher.emitasync(new orderfailedevent(orderid, error.message));

}

}

}

}

// bootstrap with bullmq

const queue = new queue('order_queue', { connection });

const worker = new worker('order_queue', new orderprocessor(...).handleordercreation, { connection });

优势:通过mq削峰填谷,将同步强一致转为异步最终一致,极大提升系统抗压能力

3 ) 方案3

分布式锁保障关键操作互斥(如库存扣减)

在高并发下单场景中,商品库存扣减极易因竞争导致超卖。传统悲观锁(select for update)虽安全但易造成锁等待甚至死锁。推荐引入redis分布式锁 + lua脚本原子化执行。

使用 ioredis 实现 redlock 风格分布式锁

// redis-lock.service.ts

import { injectable } from '@nestjs/common';

import redis from 'ioredis';

@injectable()

export class redislockservice {

private readonly redis = new redis({

host: 'redis-cluster-host',

port: 6379,

});

private readonly lock_prefix = 'lock:';

private readonly default_ttl = 5000; // 5s

async acquirelock(key: string, ttlms: number = this.default_ttl): promise<string | null> {

const lockkey = this.lock_prefix + key;

const token = date.now().tostring();

const script = `

if redis.call('get', keys[1]) == false then

return redis.call('set', keys[1], argv[1], 'px', argv[2])

else

return false

end

`;

const result = await this.redis.eval(script, 1, lockkey, token, ttlms);

return result ? token : null;

}

async releaselock(key: string, token: string): promise<boolean> {

const lockkey = this.lock_prefix + key;

const script = `

if redis.call('get', keys[1]) == argv[1] then

return redis.call('del', keys[1])

else

return 0

end

`;

const result = await this.redis.eval(script, 1, lockkey, token);

return result === 1;

}

}

库存扣减服务逻辑(集成分布式锁)

// inventory.service.ts

import { injectable } from '@nestjs/common';

import { redislockservice } from './redis-lock.service';

@injectable()

export class inventoryservice {

constructor(private readonly lockservice: redislockservice) {}

async deductstock(productid: number, quantity: number): promise<boolean> {

const lockkey = `stock:${productid}`;

let token: string | null = null;

try {

token = await this.lockservice.acquirelock(lockkey, 3000);

if (!token) {

throw new error('failed to acquire lock');

}

// 模拟数据库检查与扣减(应在事务中)

const current = await this.getcurrentstock(productid);

if (current < quantity) {

throw new error('insufficient stock');

}

await this.updatestockindatabase(productid, current - quantity);

return true;

} catch (err) {

console.error(err);

return false;

} finally {

if (token) {

await this.lockservice.releaselock(lockkey, token);

}

}

}

private async getcurrentstock(productid: number): promise<number> {

// 实际调用 typeorm / prisma 查询

return 100; // mock

}

private async updatestockindatabase(productid: number, newstock: number): promise<void> {

// 更新数据库逻辑

console.log(`updating stock for ${productid} to ${newstock}`);

}

}

引入消息队列削峰填谷,缓解数据库瞬时压力

在大促抢购场景中,可将订单创建请求放入 kafka 或 rabbitmq,后端消费者异步处理落库,避免数据库直面流量洪峰。

// order-producer.service.ts

import { injectable } from '@nestjs/common';

import { clientproxy } from '@nestjs/microservices';

@injectable()

export class orderproducerservice {

constructor(private client: clientproxy) {}

emitordercreated(payload: { userid: number; productid: number; count: number }) {

this.client.emit('order_created', payload);

}

}

// order-consumer.service.ts

@eventpattern('order_created')

async handleordercreated try {

await this.inventoryservice.deductstock(data.productid, data.count);

await this.orderrepository.save(data);

console.log('order processed:', data);

} catch (err) {

// 发送失败则进入死信队列或重试机制

console.error('order processing failed:', err);

throw err; // 触发重试

}

}

数据库层优化建议

| 优化项 | 建议 |

|---|---|

| 读写分离中间件 | 引入 mycat、shardingsphere proxy 实现自动路由 |

| 主从延迟监控 | 使用 pt-heartbeat 工具实时检测复制延迟 |

| 备份策略调整 | 全量备份在低峰期于特定从库执行,禁止主库备份 |

| 高可用升级 | 迁移至 mysql group replication(mgr)或 innodb cluster |

架构演进建议

| 问题 | 解决方案 |

|---|---|

| 主库单点故障 | 引入 mha / orchestrator 实现自动 failover |

| 复制延迟大 | 增加半同步复制(semi-sync)、优化网络拓扑 |

| 备份影响性能 | 移至专用备份 slave,使用 xtrabackup 热备 |

| 高并发写竞争 | 应用层引入分布式锁 + 乐观锁 + mq 异步化 |

| 监控缺失 | 部署 prometheus + grafana 全链路监控 |

重点强调:

- 主库必须轻量化运行,禁止执行备份、报表导出等重负载任务

- 所有关键变更必须经过压测验证

- 建立完善的灾备演练机制,确保故障切换流程自动化、分钟级完成

- 持续优化 sql 与索引策略,降低单次查询成本是提升吞吐的核心路径

结合上述现象与数据,可归纳出以下核心技术要点:

| 技术维度 | 现状问题 | 优化方向 |

|---|---|---|

| 高可用性 | 无自动failover机制,依赖人工干预 | 引入mha、orchestrator或基于raft协议的mysql group replication |

| 读写分离扩展性 | 多从库加剧主库网络压力 | 实施级联复制(cascade replication)或引入中间件代理分流 |

| 备份策略 | 主库执行远程备份引发io尖峰 | 迁移至专用备份从库,启用lvm快照或物理备份工具如percona xtrabackup |

| 监控告警体系 | 峰值被动发现,响应滞后 | 构建主动预警机制,设置qps、cpu、io延迟等多维阈值告警 |

从单一主从到弹性架构的演进路径

本文深入剖析了一家高并发电商企业在大促前夕所面临的数据库架构挑战。尽管其硬件配置强大、qps/tps表现出色,但由于主节点单点、缺乏高可用、备份策略不当、网络与io瓶颈突出等问题,系统整体健壮性严重不足

通过引入分布式锁、消息队列削峰、备份策略重构、高可用组件升级等手段,可在不改变业务语义的前提下,大幅提升系统稳定性与容灾能力。未来应逐步向分库分表 + 多主集群 + 自动容灾的云原生数据库架构演进

重点再强调:

- 主库绝不允许执行重io操作

- 高并发场景下,任何人工干预都是灾难源头

- 自动化、可观测性、容错设计是大型系统的基石

最终原则不变:任何架构演进都应服务于业务稳定性与用户体验,技术的选择永远要基于真实场景的压力测试与数据反馈

未来可进一步探索

- mysql group replication / innodb cluster 实现原生高可用

- shardingsphere 或 mycat 实现水平分片

- prometheus + grafana + alertmanager 构建立体化监控告警体系

- kubernetes operator 自动化管理数据库生命周期

结论

综上所述,尽管原始架构看似简洁,但在真实高并发场景下暴露出严重的可用性与性能瓶颈。唯有通过架构升级、技术加固与全流程监控三位一体的方式,方能在双十一类极端流量冲击下保障系统稳定运行

到此这篇关于mysql数据库: 高并发电商场景下的架构设计与优化的文章就介绍到这了,更多相关高并发场景下的mysql性能优化内容请搜索代码网以前的文章或继续浏览下面的相关文章希望大家以后多多支持代码网!

您想发表意见!!点此发布评论

发表评论