能玩3A游戏还能运行32B大模型! 散热最好的mini主机奥睿科OminiPro评测

163人参与 • 2025-12-03 • 游戏引擎

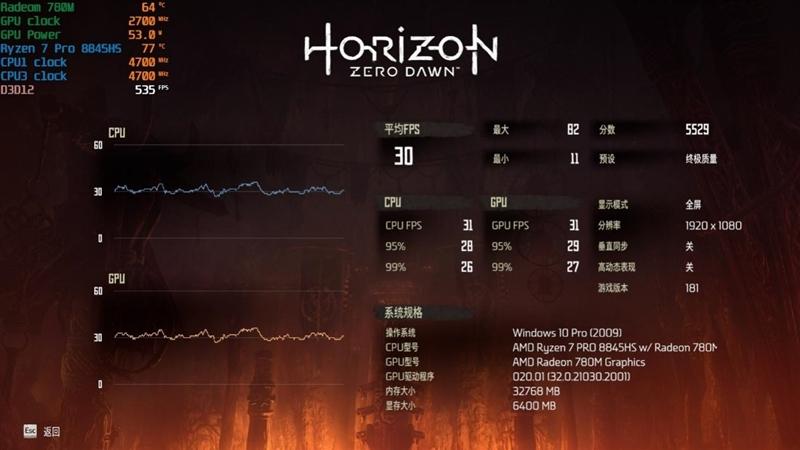

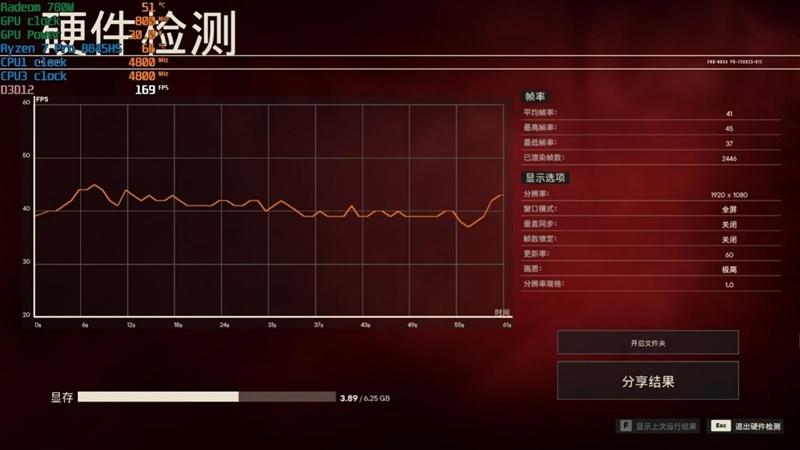

4、地平线:零之曙光

5、孤岛惊魂5

6、孤岛惊魂6

7、古墓丽影:暗影

8、绝地求生

9、赛博朋克2077

10、巫师3

11、无主之地3

12、战争机器5

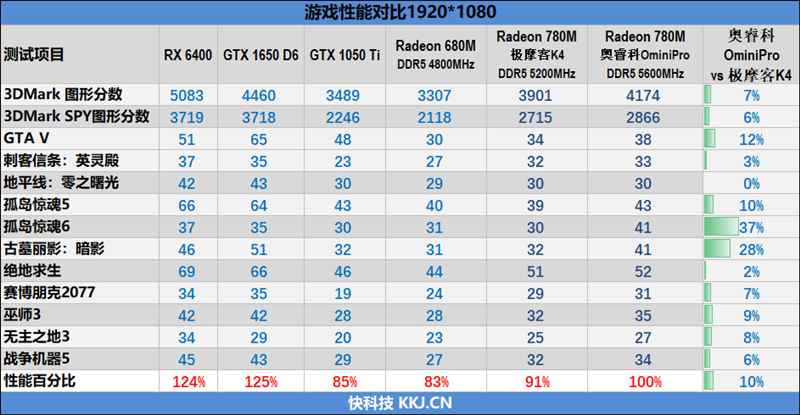

测试数据汇总如下:

和极摩客k4的radeon 780m相比,奥睿科ominipro的游戏性能要强了10%左右,主要还是因为它的55w的性能释放比后者高了整整10w的原因。

和独显相比,奥睿科ominipro的性能已经超越gtx 1050 ti,领先幅度约为18%。与rx 6400和gtx 1650 d6这样的独显相比,差距也只有25%左右。

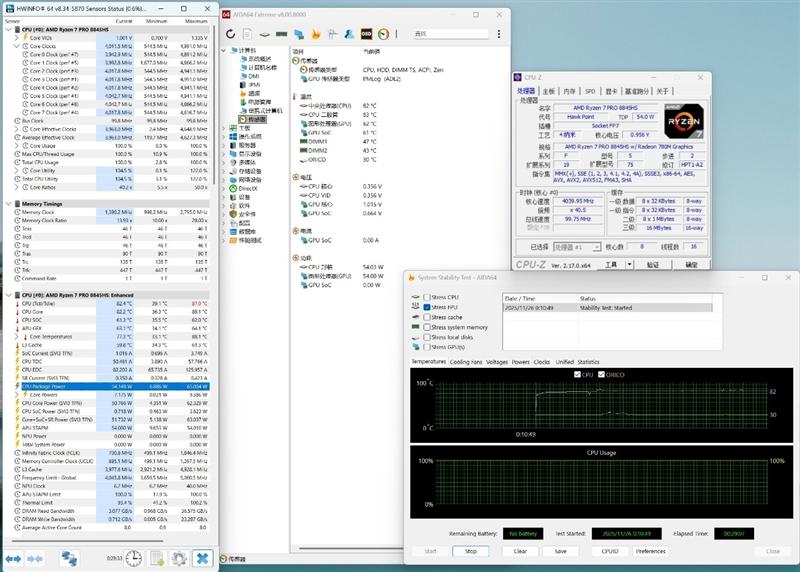

五、温度与磁盘性能测试:烤机半小时稳定54w性能释放 温度仅82度

1、烤机测试

测试时室温为24度。

我们使用aida64 fpu进行了长达半小时的烤机测试,奥睿科ominipro可以稳定54w的性能释放,锐龙7 pro 8845hs全核频率4ghz,温度82度。

2、磁盘性能测试

奥睿科ominipro内置一块定制pcie 4.0 1tb ssd。

as ssd benchmark总分为3796,顺序读写分别为4029mb/s、2544mb/s、4k随机读写分别为62mb/s、169mb/s。

crystaldiskmark 64gb测试环节,顺序读写速度分别为4154mb/s、2819mb/s。

六、ai性能出色 可运行qwen-32b大模型

根据我们对奥睿科omini主机pro在处理器与集成显卡方面的多项测试来看,这款迷你主机在性能释放上表现相当出色,cpu与gpu均具备强劲实力,不仅能轻松应对日常办公与娱乐需求,在图形处理与多任务运行中也游刃有余。那么,在如今备受关注的ai应用领域,它又能带来哪些可能?

自chatgpt走红以来,生成式ai的浪潮已席卷全球各行各业。特别是随着deepseek-r1等系列大模型的发布,本地化部署大模型成为新的趋势。然而,本地运行大模型对硬件提出极高要求,不仅需要强大的算力支撑,更依赖大容量的显存与内存配合。目前市面上主流的32gb内存轻薄本,通常仅能流畅运行参数量在14b及以下的大模型;即便搭配高性能独显如rtx 5090笔记本电脑gpu,最高也仅能支持到32b模型,难以让用户体验更大规模ai模型的真正魅力。

我们测试的这台奥睿科omini主机pro,搭载amd锐龙7 pro 8845hs处理器,集成npu提供16 tops的ai算力,并配备32gb ddr5内存。在这样的配置下,它在ai任务中表现如何?

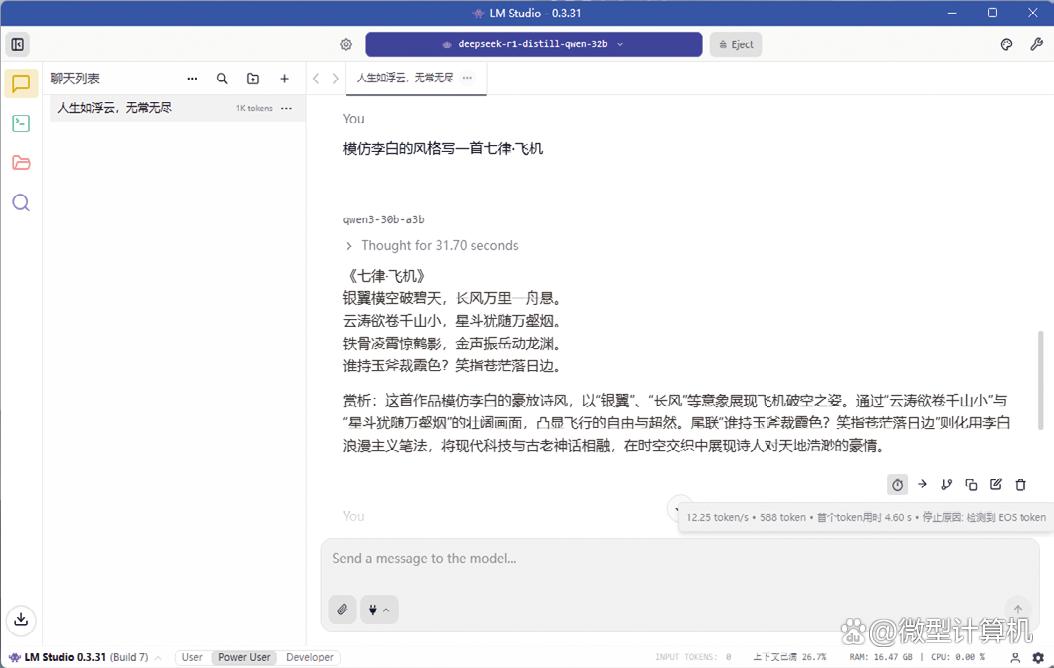

我们使用lm studio软件部署了多个当前热门的大模型进行实测。在运行q4量化版的qwen3-30b-a3b模型时,该主机达到了12.25 tokens/s的推理速度,整体响应流畅,体验良好。

▲在运行q4量化版的qwen3-30b-a3b模型时,该主机实现了12.25 tokens/s的推理速度。

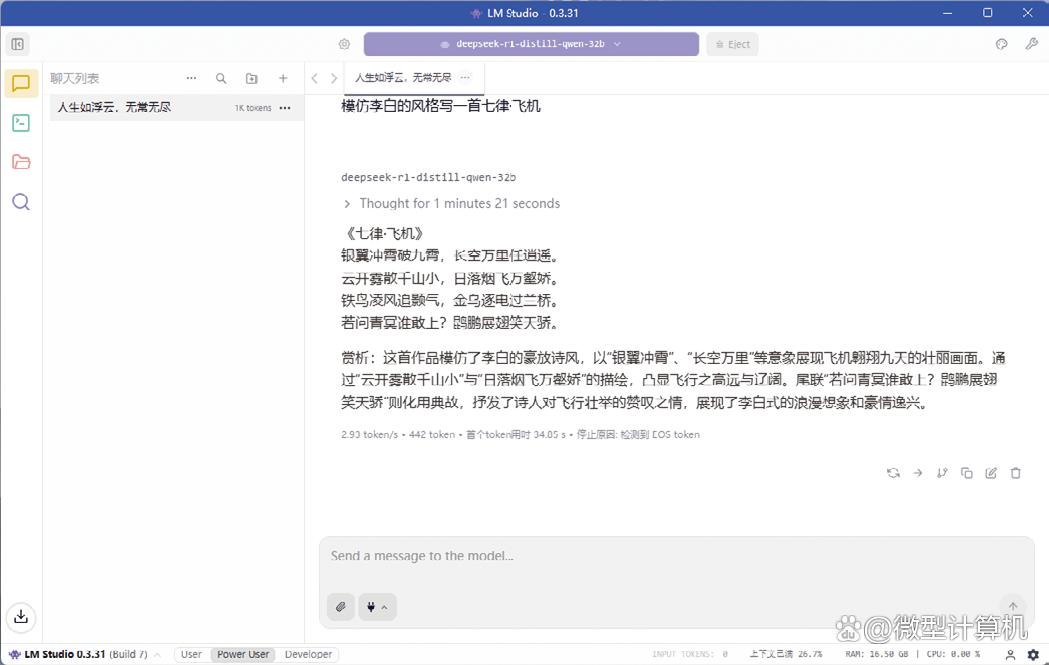

▲挑战更高参数的deepseek-r1-distill-qwen-32b模型时,该主机的推理速度仍有2.93 tokens/s。

进一步挑战更高参数的deepseek-r1-distill-qwen-32b模型时,在同样q4量化设置下,主机的推理速度为2.93 tokens/s。尽管响应不算特别流畅,但仍可正常运行。值得注意的是,多数同内存容量的轻薄本在运行14b以上模型时已显吃力,部分甚至无法加载32b模型。由此可见,奥睿科omini主机pro在锐龙7 pro 8845hs的加持下,展现出优于同级的ai推理能力,让普通用户也能在本地尝鲜更大规模的ai模型,拓展了迷你主机的应用边界。

七、预装orico ai助手 玩法多样

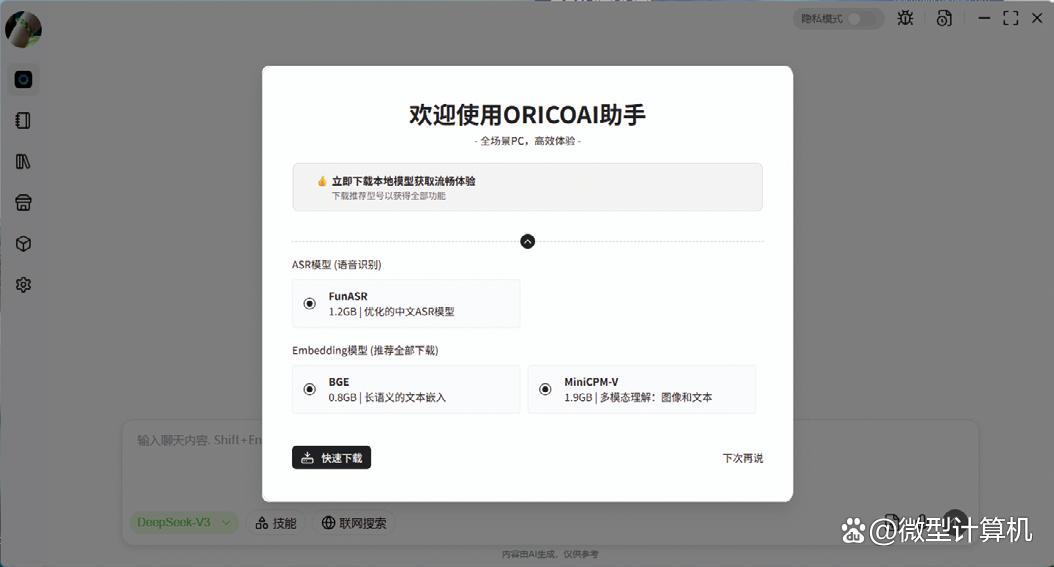

相信很多用户通常使用最多的是文心一言、豆包和deepseek在线版的大模型,而如果想要部署本地大模型,需要掌握熟练的技巧,门槛相对较高。为了方便大众用户使用到更多类型的大模型,奥睿科omini主机pro还特别预装了“orico ai助手”app。

▲奥睿科omini主机pro预装有ai助手,支持部署本地大模型。

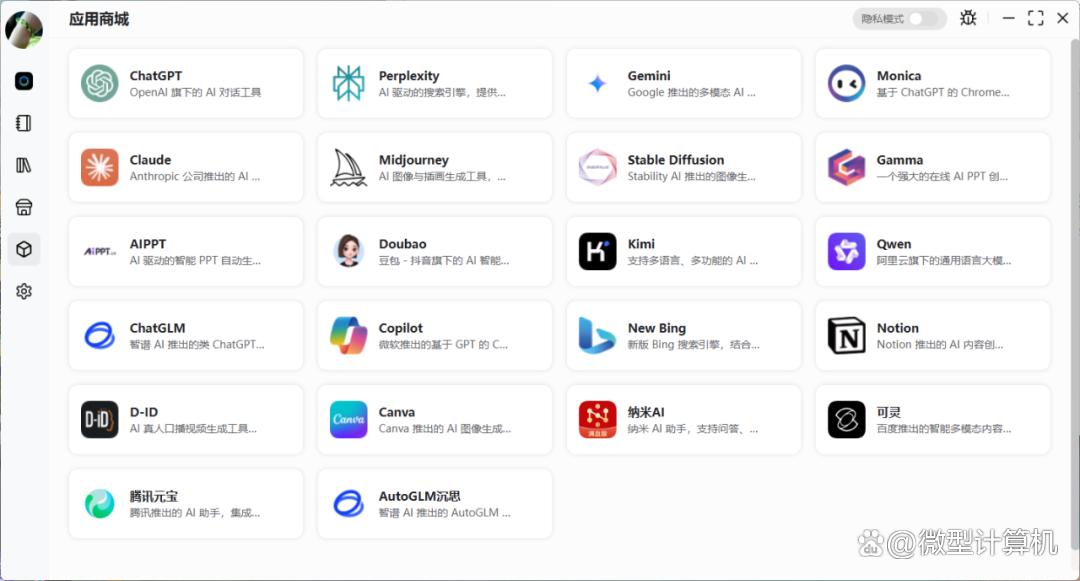

打开app并登录后,界面会提示下载基于asr模型(语音识别)和embedding模型(包含beg长语义的文本嵌入和minicpm-v多模态理解)。该app中的应用商城提供了目前市面上主流的ai工具,比如国内常见的qwen、豆包、纳米ai和腾讯元宝,还有国外的chatgpt、gemini以及stable diffusion等。这都不是重点,最关键的是该app支持部署本地ai大模型,比如可以直接在模型商店一键下载部署qwen3:14b、deepseek-r1:14b、qwen3-30b-a3以及最新的qwen3:30b-a3b-2507等大模型。值得注意的是,像30b这类较大规模的大模型在现有的硬件配置上无法直接下载部署,需要用户升级更大的内存后才能使用。对于日常办公、学习来说,14b的模型就能满足使用。

▲ai助手中的模型商店里提供了多个不同规模的大模型可直接下载部署到本地使用

除了可以一键部署本地大模型外,该app还支持搭建本地知识库和上传笔记,两大功能与本地大模型深度联动,既解决了分散资料的管理痛点,又让大模型的交互更贴合个人需求,大幅提升ai工具的实用价值。

其中,本地知识库能帮你将工作中的项目方案、客户资料,学习时的专业教材、论文文献、课程笔记甚至个人经验总结等各类内容,统一上传至本地知识库,无须担心资料散落在云端网盘、本地文件夹或不同办公软件中,实现“一站式”集中管理。更重要的是,知识库与本地大模型深度绑定,大模型会快速学习并理解这些专属资料,当你需要检索信息时,无须手动翻找文件,只需提问(比如“提取xx方案报告”“解读xx产品的关键技术”),大模型就能从知识库中精准定位相关内容,快速给出总结、解读或原文引用,比传统搜索工具效率提升数倍。

▲ai助手中有多种模型

更关键的是,所有资料均存储在奥睿科omini主机pro本地,依托主机的硬件安全防护,敏感信息不会上传云端,既避免了数据泄漏风险,又能让大模型的回答更贴合你的行业场景、工作习惯或学习重点,真正实现“专属ai顾问”的体验。

该app还支持上传笔记功能,它目前仅支持直接上传txt文本,暂不支持上传pdf、音频和图片。如果需要上传图片,可以在上传的文本里面通过插入图片的方式上传。你可以随时将碎片化的会议记录、待办事项同步至app,这些笔记会自动融入本地知识库,成为大模型的“实时学习素材”。比如开会时记录的核心需求,上传后大模型可直接基于这些内容生成执行方案;学习时标注的重点难点,也能让大模型针对性补充拓展,让ai交互从“通用问答”升级为“个性化服务”,适配办公、学习和创作等多元场景。结合奥睿科omini主机pro的32gb大内存与16 tops npu算力,即便知识库存储海量资料,大模型的检索与交互依旧流畅无卡顿,让普通用户也能轻松拥有高效、安全和个性化的本地ai生态。

八、小结:解决了散热烦恼的mini主机

此前我们测试过不少迷你主机,比如小米和morefine魔方m600迷你主机,它们在45w的功耗下烤机10分钟,cpu温度能到90度。搭载锐龙9 7940hs的极摩客k4,也需要90度的高温才能保证45w的性能释放。

而奥睿科ominipro我们进行了长达半小时的烤机测试,其搭载的锐龙7 pro 8845hs处理器能始终保持54w的性能释放,而且温度仅有82度。

也就是说,奥睿科ominipro能在性能释放高9w的情况下,核心温度还低了8度。

反映到性能上,对比搭载性能更强的锐龙9 7940hs主机的极摩客k4迷你主机,奥睿科ominipro的多核性能能有6%的优势,游戏性能则能领先10%左右。

当然温度更低也意味着主机噪音更低。

p.s.小米迷你主机若是解锁45w性能释放,风扇噪音会大到难以忍受。

传统的atx主机体积在40l左右,大量占用了本来就不多的办公桌面空间。而奥睿科ominipro的体积仅有1l左右,相当于传统台式机的1/40,可以任意放在任何合适的地方,就算是外出带着也完全没有任何问题。

如果你想要一台能玩3a游戏的主机,大部分迷你电脑显然不行(其实奥睿科ominipro在主流3a游戏中,1080p最高画质下都能保证30~40fps的帧率,也不是不能玩)

但是如果你只是需求一台用于办公娱乐的主机,从各方面来说,台式机真的已经out了。

一台超迷你的主机可以省却很多烦恼,虽然初期采购费用贵了那么一点,但是节省的空间、电费足够值回成本。

您想发表意见!!点此发布评论

发表评论