Docker下Open WebUI,Ollama的安装实践

393人参与 • 2024-08-01 • Windows Phone

提示一下open webui与ollama的关系。后端的同学可以理解为open webui等于是个navicat,ollama就是具体的数据库实例。

官方安装文档:

open webui官网文档翻译:

注意:

安装默认配置

1.如果您的计算机上安装了ollama,可以使用以下命令:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main2.如果ollama在另一台服务器上,请使用以下命令:

连接到另一台服务器上的ollama时,请将ollama_base_url更改为服务器的url:

docker run -d -p 3000:8080 -e ollama_base_url=https://example.com -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main要使用nvidia gpu支持运行open webui,请使用以下命令:

docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda3.仅用于openai api使用的安装

如果您仅使用openai api,请使用以下命令:

docker run -d -p 3000:8080 -e openai_api_key=your_secret_key -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main 4.带有捆绑ollama支持的open webui安装

此安装方法使用一个单独的容器映像,将open webui与ollama捆绑在一起,通过单个命令实现简化设置。根据您的硬件设置选择适当的命令:

使用gpu支持:通过运行以下命令利用gpu资源

docker run -d -p 3000:8080 --gpus=all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama 仅cpu:如果您不使用gpu,请改用以下命令:

docker run -d -p 3000:8080 -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama 这两个命令都支持内置、简单的安装open webui和ollama,确保您可以快速启动一切。

安装完成后,您可以通过http://localhost:3000访问openwebui。祝您使用愉快

5.其他安装方法

我们提供各种安装替代方案,包括非docker本机安装方法、docker compose、kustomize和helm。请访问我们的open webui文档或加入我们的discord社区以获取全面指导。

故障排除

如果您遇到诸如“open webui: 服务器连接错误”等问题,请查看故障排除,了解如何排查问题,或加入我们的open webui discord社区。 保持docker安装最新

如果您想将本地docker安装更新到最新版本,可以使用watchtower:

docker run --rm --volume /var/run/docker.sock:/var/run/docker.sock containrrr/watchtower --run-once open-webui 在命令的最后部分,如果容器名称不同,请将open-webui替换为您的容器名称。

继续完整的入门指南。

🚀 getting started | open webui

6.实践

这里既然都玩大模型了,没有人还会没有一块3090吧

这里使用连接到其他主机上的ollama

docker run -d -p 3000:8080 -e ollama_base_url=https://example.com -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

博主的命令为:

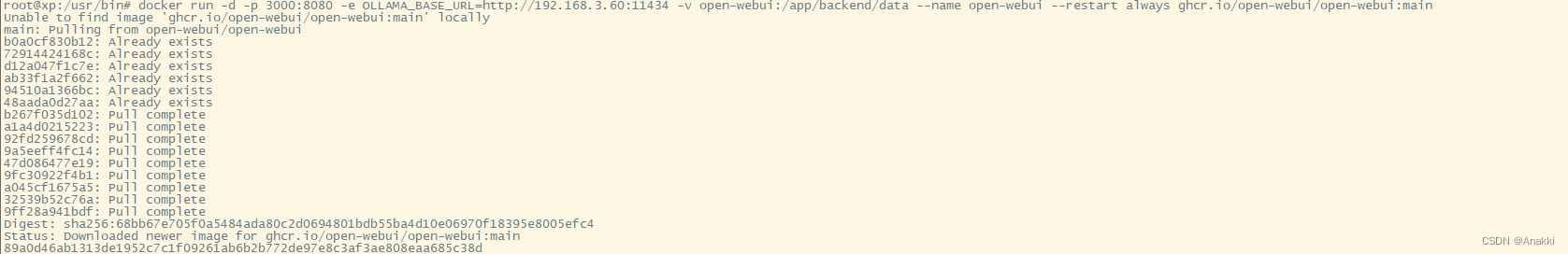

docker run -d -p 3000:8080 -e ollama_base_url=http://192.168.3.60:11434 -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

由于我安装的ollama在另外一台局域网服务器。这里将 ollama_base_url=https://example.com的https://example.com改成你ollama部署的机器的ip。端口默认是11434

这里有点慢,等一等----------1小时左右。

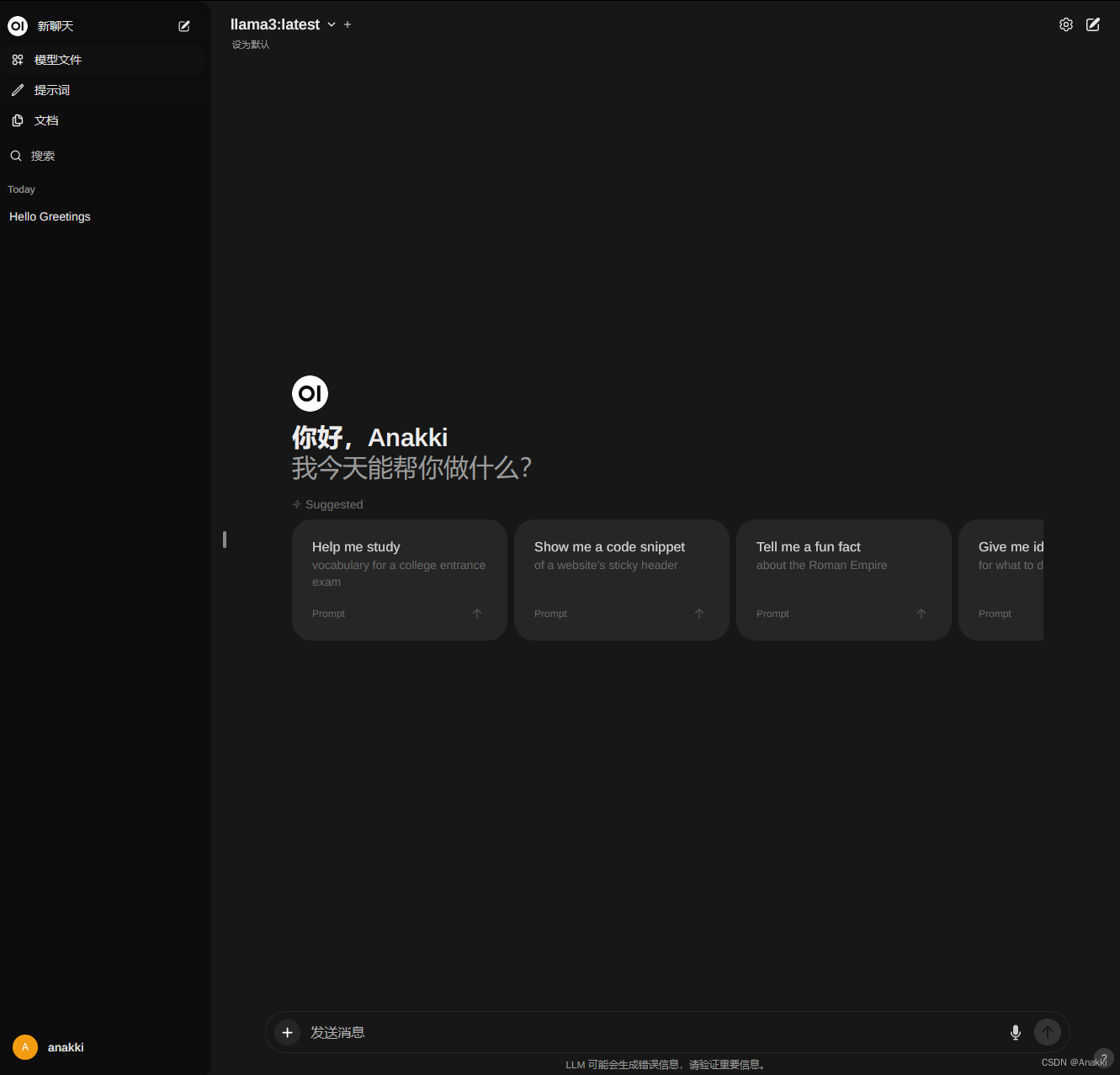

当安装好ollama后,openwebui也安装好后,访问openwebui部署的机器ip+3000端口 就可以访问ui页面了

这里openwebui内嵌到我的个人网站了。大家可以注册用户,与ollama 8b模型对话。

个人网站-ollama页面:

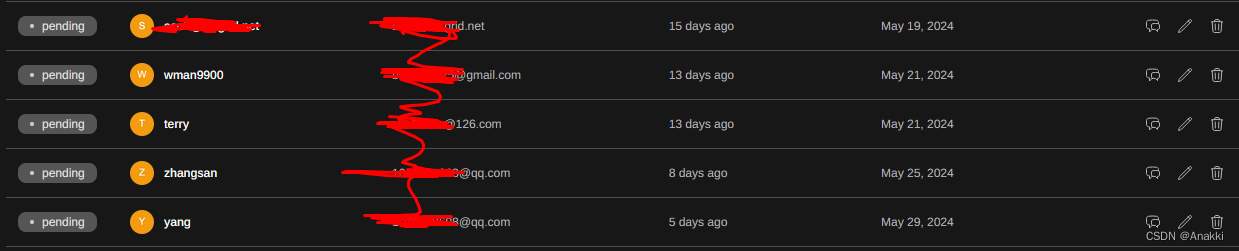

大家注册上来一定要留真实邮箱,这样注册过的用户我会发送确认邮件,这样你们的账户才会生效,就可以使用我本机的3090显卡回答你的问题了~

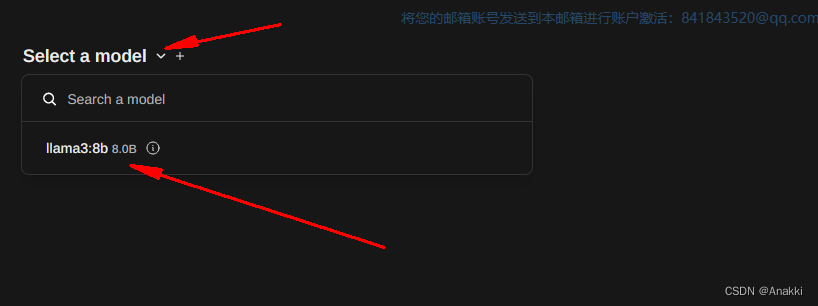

注册进来后记得选择模型!!!不然会提示你先选择模型。

您想发表意见!!点此发布评论

发表评论