详解DeepSeek如何通过Ollama解决常见本地部署报错问题

50人参与 • 2025-02-08 • 其他编程

在本篇文章中,我们将详细探讨deepseek通过ollama本地部署时可能遇到的几种常见报错问题,并提供解决方案。涉及的问题包括模型下载速度慢、连接错误、无法在chatbox中找到已下载的模型以及如何更改模型下载位置等。

1. 模型下载速度太慢,如何解决?

有不少用户反映在通过ollama下载模型时,下载速度非常慢,甚至无法顺利完成下载。以下是一个有效的解决方法:

解决方法:

尝试按下ctrl+c取消下载,然后重新开始下载: 一些用户反馈,在下载过程中按下ctrl+c取消下载,再重新开始时,下载速度反而变得更快。这是因为在某些情况下,重新连接可能会绕过网络拥堵或者提升下载路径的速度。

此外,你也可以尝试以下方法来提升下载速度:

- 更换网络环境: 有时下载速度慢可能是由于网络问题,尝试切换到更稳定的网络环境,或使用加速器。

- 使用代理服务器: 可以在ollama的配置中设置代理服务器,帮助绕过本地网络的限制。

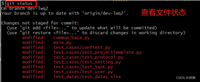

2. 错误信息:error: post "http://127.0.0.1:11434/api/show": dial tcp 127.0.0.1:11434: connectex: no connection could be made because the target machine actively refused it.

这个错误通常表示ollama本地服务没有正常启动,或者网络配置有问题。解决方法如下:

解决方法:

检查ollama服务是否已启动: 确保ollama服务正在本地运行。输入以下命令来查看端口11434是否被占用:

netstat -an | findstr 11434

如果端口被占用,你会看到类似以下的输出:

tcp 0.0.0.0:11434 0.0.0.0:0 listening

这意味着端口11434已经被占用。如果没有看到输出,则表示端口空闲。

macos/linux操作系统:

打开终端。

输入以下命令来检查端口占用情况:

lsof -i :11434

如果端口被占用,会显示相关进程的信息。如果没有输出,说明端口没有被占用。

检查防火墙设置: 该错误有可能是防火墙拦截了ollama服务的端口。你可以尝试暂时关闭防火墙,或者在防火墙设置中允许端口11434通过。

检查端口冲突: 确认本地没有其他程序占用了端口11434,你可以通过更改ollama的端口配置来避免冲突。

更改ollama的端口配置

如果发现端口11434已被占用,可以通过更改ollama的端口来避免冲突。以下是更改端口的具体方法:

windows和macos/linux操作系统:

找到ollama的配置文件,通常是一个config.json或类似的配置文件,路径可能如下:

- windows: c:\users\<yourusername>\.ollama\config.json

- macos/linux: ~/.ollama/config.json

打开配置文件,找到与端口相关的设置项,列如:11434或类似的字段。将11434更改为一个未被占用的端口号,例如11435或其他较高的端口号

json

{ "port": 11434 }

json

{ "port": 11435 }

也可以通过配置环境变量来解决,右键我的电脑,属性,高级系统设置,新建环境变量。

变量名:ollama_host

值:0.0.0.0:11435

3. chatbox中无法找到已下载的模型

如果你在使用ollama的chatbox时,无法找到已经下载的模型,可能是由于模型路径配置的问题。

解决方法:

检查模型文件是否在正确的目录中: 默认情况下,ollama会将模型存储在指定的本地目录中。如果你无法在chatbox中找到模型,请首先检查该目录,确认模型文件是否确实存在。

确保正确配置了ollama的模型路径: 你可以在ollama的设置中查看并配置模型文件的路径。确保该路径指向你下载模型的正确位置。

如果在上一步中更改了域名位置,那么只需要更改你api的域名即可。

4. 如何查看自己本地下载的模型的位置?

要查看自己本地下载的模型的位置,你可以通过以下两种方法:

方法一:

在ollama的设置中,通常会提供一个“模型存储路径”选项。在这个选项中,你可以看到所有下载的模型的存储位置。

方法二:

如果你不确定ollama的存储路径,可以通过文件搜索工具,查找已下载模型的文件名或者模型的文件类型。一般来说,模型的文件名包含模型的名称或者版本号。

5. 如何更改模型下载位置?

如果你希望将ollama下载的模型存储在特定的目录,可以通过更改ollama的配置来实现。

解决方法:

修改ollama配置文件: 打开ollama的配置文件(通常是config.json),并找到与“模型路径”相关的字段。在此字段中,你可以指定模型的下载路径。

使用命令行参数: 在启动ollama时,部分版本支持通过命令行参数来指定模型下载目录。请查看ollama的文档,了解是否支持此功能。

例如,你可以在启动ollama时,使用类似以下的命令:

ollama --model-dir "d:/my_models"

这将把模型下载到d:/my_models目录下。

也可以通过配置环境变量来解决,右键我的电脑,属性,高级系统设置,新建环境变量。

变量名:ollama_ms

值:新建文件夹路径

结语

通过上述解决方法,你应该能够顺利解决在使用deepseek和ollama本地部署过程中遇到的常见问题。

到此这篇关于详解deepseek如何通过ollama解决常见本地部署报错问题的文章就介绍到这了,更多相关deepseek ollama解决本地部署报错内容请搜索代码网以前的文章或继续浏览下面的相关文章希望大家以后多多支持代码网!

微信扫一扫

微信扫一扫

您想发表意见!!点此发布评论

发表评论