DeepSeek-R1本地部署配置要求一览(建议收藏)

248人参与 • 2025-02-07 • 工具软件

在发布[deepseek本地部署 引用]后,有不少读者私信询问本地部署deepseek-r1的电脑配置要求。

收到,本文来一起看看deepseek每个版本的配置要求及适合场景。

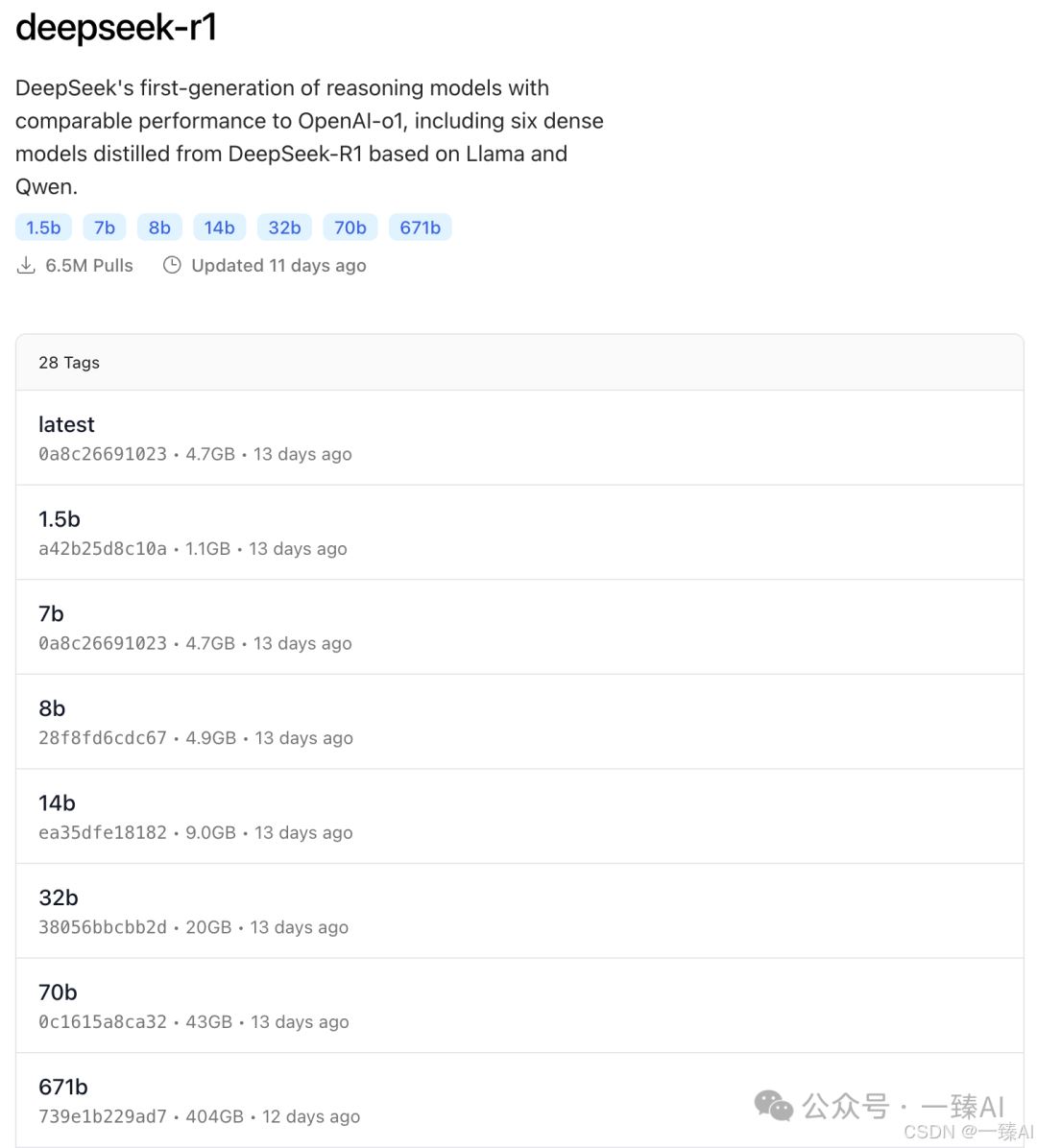

根据 ollama 平台提供的 deepseek-r1 模型信息,以下是不同参数量模型的本地部署硬件要求和适用场景分析。

注:部分数据基于模型通用需求推测,具体以实际部署测试为准。

1、deepseek-r1-1.5b

- cpu: 最低 4 核(推荐 intel/amd 多核处理器)

- 内存: 8gb+

- 硬盘: 3gb+ 存储空间(模型文件约 1.5-2gb)

- 显卡: 非必需(纯 cpu 推理),若 gpu 加速可选 4gb+ 显存(如 gtx 1650)

- 场景:

- 低资源设备部署(如树莓派、旧款笔记本)

- 实时文本生成(聊天机器人、简单问答)

- 嵌入式系统或物联网设备

2、deepseek-r1-7b

- cpu: 8 核以上(推荐现代多核 cpu)

- 内存: 16gb+

- 硬盘: 8gb+(模型文件约 4-5gb)

- 显卡: 推荐 8gb+ 显存(如 rtx 3070/4060)

- 场景:

- 本地开发测试(中小型企业)

- 中等复杂度 nlp 任务(文本摘要、翻译)

- 轻量级多轮对话系统

3、deepseek-r1-8b

- 硬件需求: 与 7b 相近,略高 10-20%

- 场景:

- 需更高精度的轻量级任务(如代码生成、逻辑推理)

4、deepseek-r1-14b

- cpu: 12 核以上

- 内存: 32gb+

- 硬盘: 15gb+

- 显卡: 16gb+ 显存(如 rtx 4090 或 a5000)

- 场景:

- 企业级复杂任务(合同分析、报告生成)

- 长文本理解与生成(书籍/论文辅助写作)

5、deepseek-r1-32b

- cpu: 16 核以上(如 amd ryzen 9 或 intel i9)

- 内存: 64gb+

- 硬盘: 30gb+

- 显卡: 24gb+ 显存(如 a100 40gb 或双卡 rtx 3090)

- 场景:

- 高精度专业领域任务(医疗/法律咨询)

- 多模态任务预处理(需结合其他框架)

6、deepseek-r1-70b

- cpu: 32 核以上(服务器级 cpu)

- 内存: 128gb+

- 硬盘: 70gb+

- 显卡: 多卡并行(如 2x a100 80gb 或 4x rtx 4090)

- 场景:

- 科研机构/大型企业(金融预测、大规模数据分析)

- 高复杂度生成任务(创意写作、算法设计)

7、deepseek-r1-671b

- cpu: 64 核以上(服务器集群)

- 内存: 512gb+

- 硬盘: 300gb+

- 显卡: 多节点分布式训练(如 8x a100/h100)

- 场景:

- 国家级/超大规模 ai 研究(如气候建模、基因组分析)

- 通用人工智能(agi)探索

通用建议

- 量化优化:使用 4-bit/8-bit 量化可降低显存占用 30-50%。

- 推理框架:搭配 vllm、tensorrt 等加速库提升效率。

- 云部署:70b/671b 建议优先考虑云服务以弹性扩展资源。

- 能耗注意:32b+ 模型需高功率电源(1000w+)和散热系统。

选择合适的deepseek版本不仅要考虑硬件配置,还要根据实际应用场景来决定。建议先从较小的模型开始尝试,逐步升级到更大的模型。这样可以在确保性能的同时,避免资源浪费。

赞 (0)

打赏

微信扫一扫

微信扫一扫

微信扫一扫

微信扫一扫

您想发表意见!!点此发布评论

发表评论