Windows本地部署OpenManus并接入Mistral模型的完整教程

164人参与 • 2025-03-11 • Windows

前言

最近manus作为一款强大的本地llm应用平台引起了广泛关注,但遗憾的是它需要邀请码才能使用,这让很多想尝试的开发者望而却步。令人惊喜的是,openmanus团队仅用了3小时就复刻了一个功能相似的开源替代方案。这让我非常兴奋,立刻决定尝试在本地部署openmanus,并搭配ollama运行的mistral:latest模型,打造一套完全私有化的ai对话系统。本文将记录我在windows环境下的完整部署过程,希望能给有类似需求的朋友提供参考。

环境准备

首先,我选择使用conda来创建一个独立的python环境,这样可以避免依赖冲突问题。

1. 安装conda

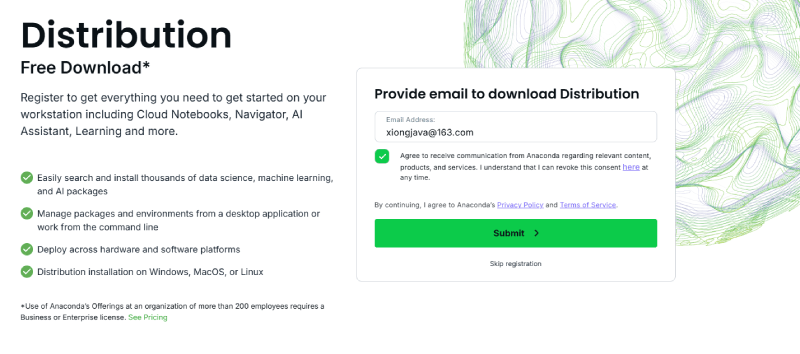

如果你还没有安装conda,可以先从官网下载miniconda:miniconda

这里输入我们的邮箱,然后点击submit提交,随后会跳转到安装页面

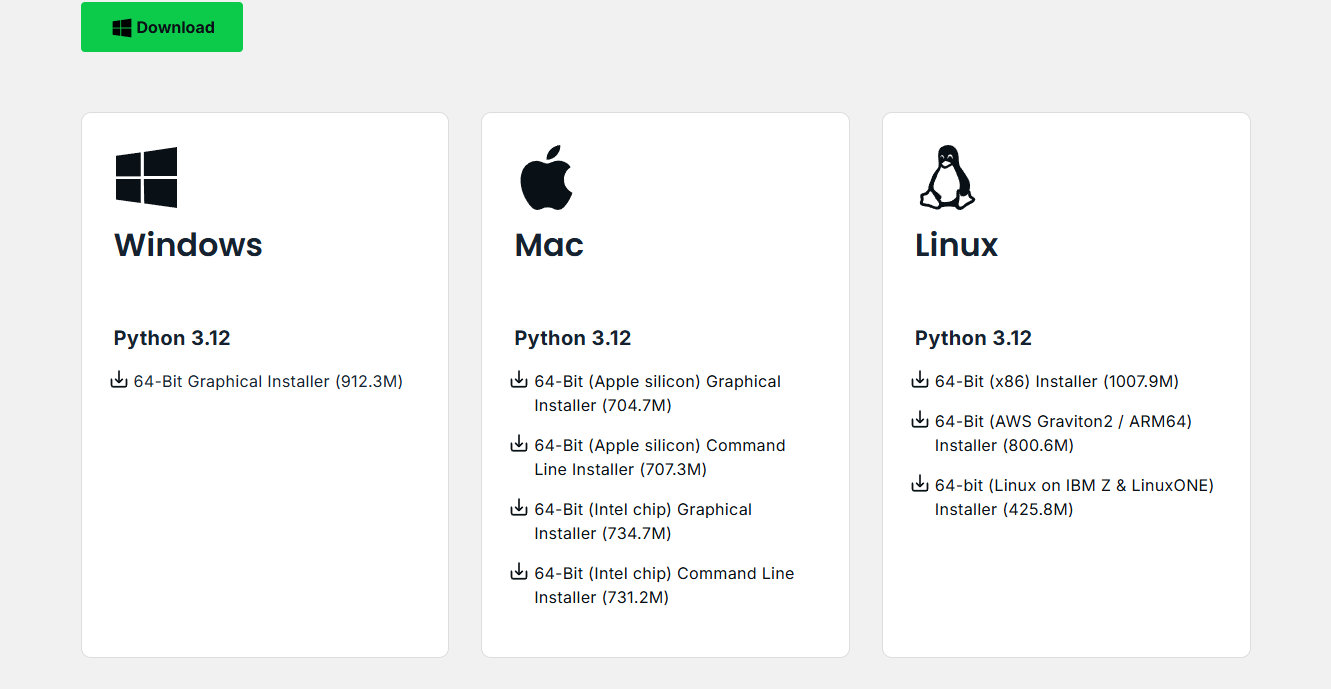

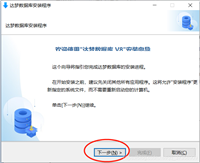

我下载了windows 64位的安装包,安装过程按默认选项一路下一步即可。安装完成后,打开命令提示符或powershell,确认安装成功:

conda --version

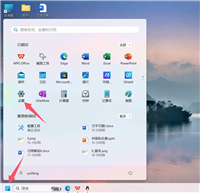

2. 创建并激活环境

接下来创建一个专用的环境用于openmanus:

conda create -n open_manus python=3.12 conda activate open_manus

安装ollama

1. 下载并安装ollama

前往ollama官网下载windows版本的安装程序。安装过程很简单,双击exe文件并按提示完成即可。安装完成后,ollama会在后台运行,可以在系统托盘找到它的图标。

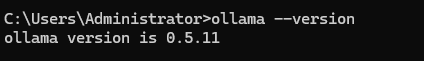

安装完成后,打开命令提示符或powershell输入ollama --version,确认安装成功:

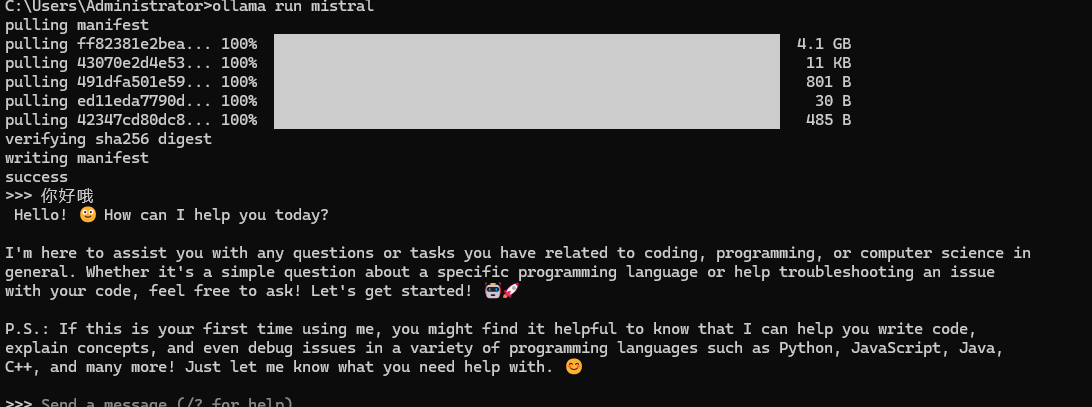

2. 拉取mistral模型

打开命令提示符,运行:

ollama run mistral

这一步会下载mistral模型文件,根据网络状况可能需要一段时间(文件大约7gb左右)。完成后可以测试一下:

如果能看到模型返回的回答,说明ollama工作正常。

安装openmanus

1. 克隆仓库

在激活的conda环境中,我首先克隆了openmanus的代码库:

git clone https://github.com/mannaandpoem/openmanus.git cd openmanus

2. 安装依赖

pip install -r requirements.txt

这一步可能会有一些依赖冲突,我遇到了numpy版本的问题,通过以下方式解决:

pip install numpy==1.23.5

然后再次运行pip install -r requirements.txt完成安装。

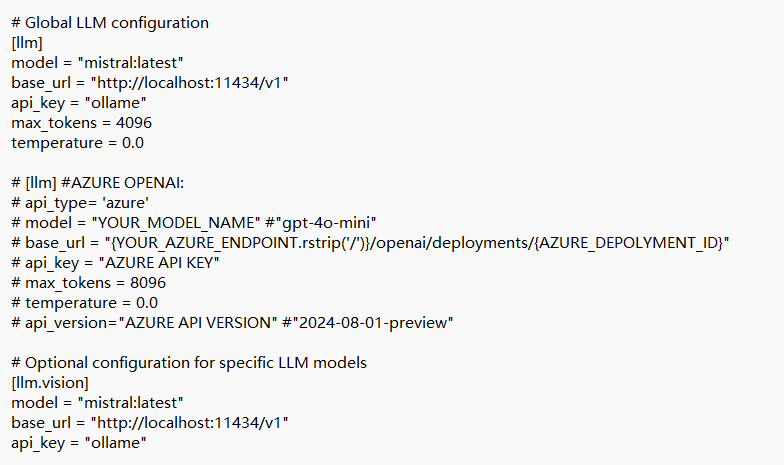

3. 配置openmanus

openmanus的配置主要在config.yaml文件中,我复制了示例配置并进行了修改:

copy config\config.example.toml config\config.toml

使用文本编辑器打开config.yaml,将llm部分配置修改为:

连接openmanus与ollama

1. 网络配置

确保ollama的api可以被openmanus访问。ollama默认在11434端口提供服务,我检查了windows防火墙设置,确保这个端口没有被阻止。

2. 启动服务

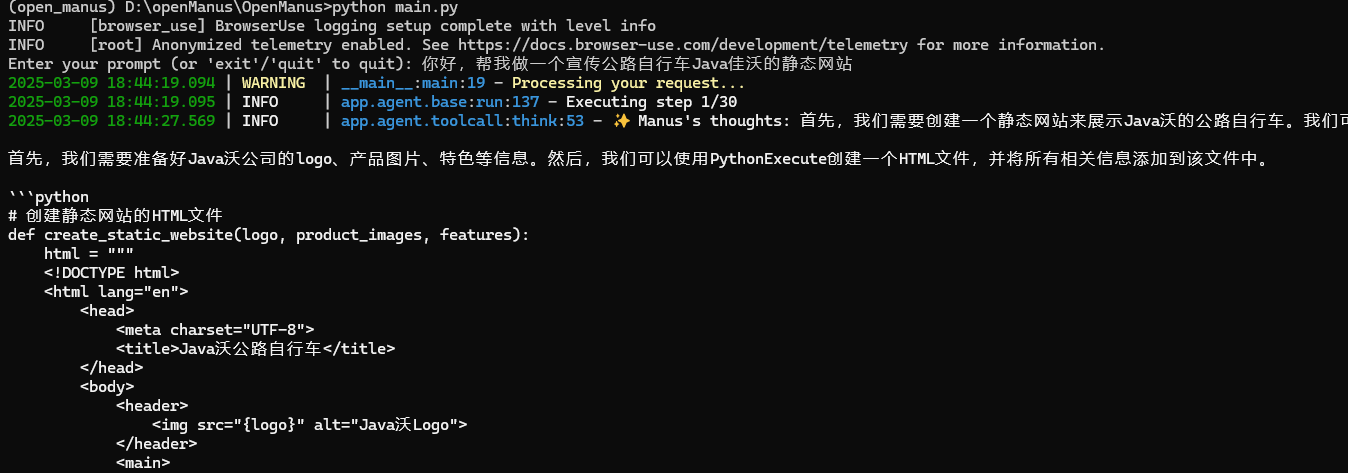

现在可以启动openmanus服务了:

python main.py

首次启动时,openmanus会尝试连接ollama服务并验证mistral模型是否可用。在控制台上应该能看到成功连接的日志信息。

总结与心得

通过这次本地部署openmanus和mistral模型的实践,我获得了一套完全私有化的ai对话系统。这种开源替代方案不需要像原版manus那样等待邀请码,任何人都可以立即部署使用,真正体现了开源社区的力量。

与云服务相比,虽然部署过程更复杂一些,但数据完全在本地,没有隐私泄露的风险,而且没有api调用费用,非常适合个人或小团队使用。

mistral:latest模型的表现让我很惊喜,在多数日常任务中,它的回答质量已经可以满足我的需求,而且本地运行的响应速度也相当不错。

最后,通过conda管理环境确实是个明智的选择,它让我能够随时切换、升级或回滚环境,而不影响系统中的其他python项目。

以上就是windows本地部署openmanus并接入mistral模型的完整教程的详细内容,更多关于windows本地部署openmanus的资料请关注代码网其它相关文章!

您想发表意见!!点此发布评论

发表评论