Ollama + Openwebui 本地部署大型模型与交互式可视化聊天

351人参与 • 2024-08-06 • 交互

ollama简介

ollama是一个创新的平台,它允许用户在本地启动并运行大型语言模型。它提供了一个简单易用的内容生成接口,类似于openai,但无需开发经验即可直接与模型进行交互。ollama支持热切换模型,为用户提供了灵活性和多样性。

安装ollama

要安装ollama,请访问官方网站的下载页面:ollama下载页面。在这里,你可以根据你的操作系统选择合适的版本进行下载,目前,ollama支持macos 11 big sur或更高版本。

macos用户

对于macos用户,可以直接点击下载链接获取ollama的压缩包:download for macos。

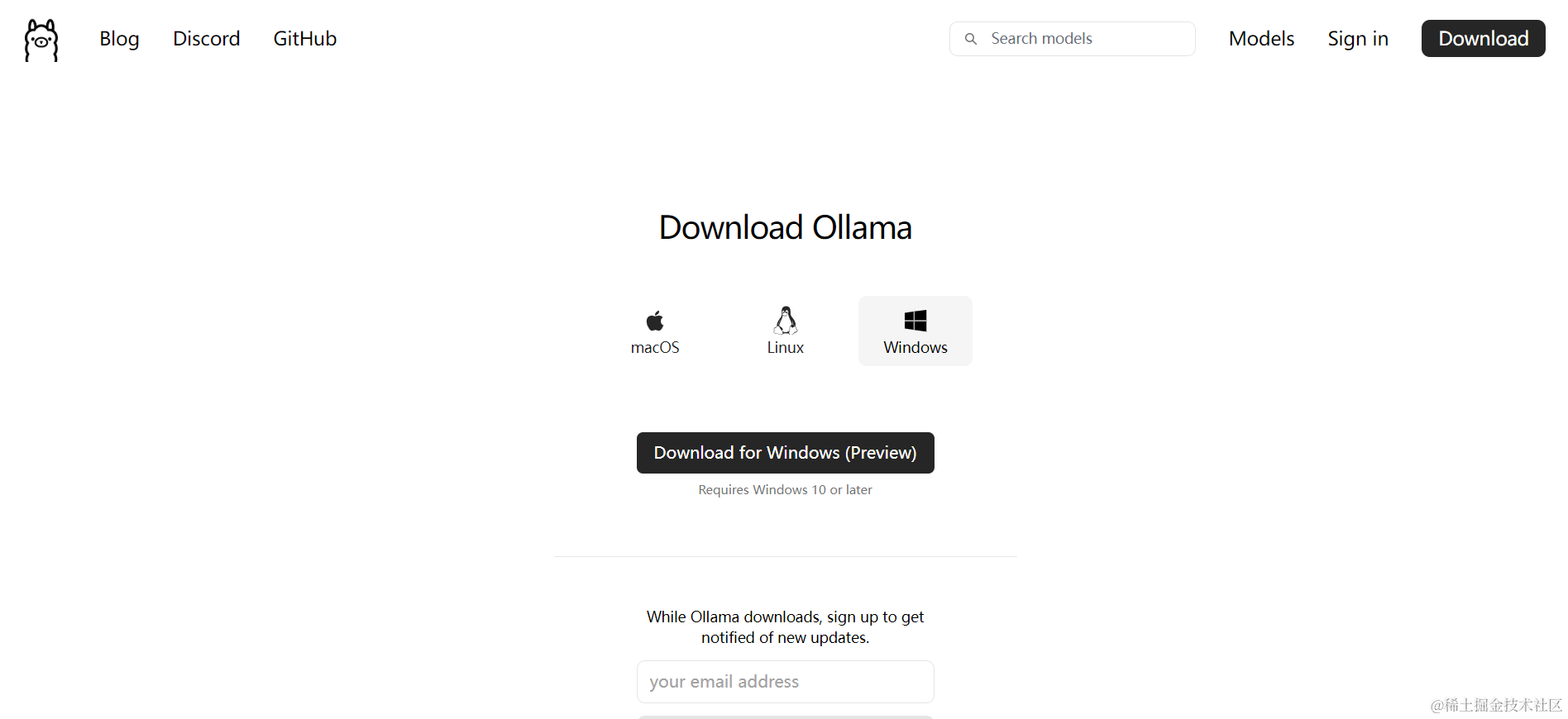

windows用户

对于windows用户,可以参照上述链接中的步骤进行安装,安装过程中,你可以通过注册来接收新更新的通知。

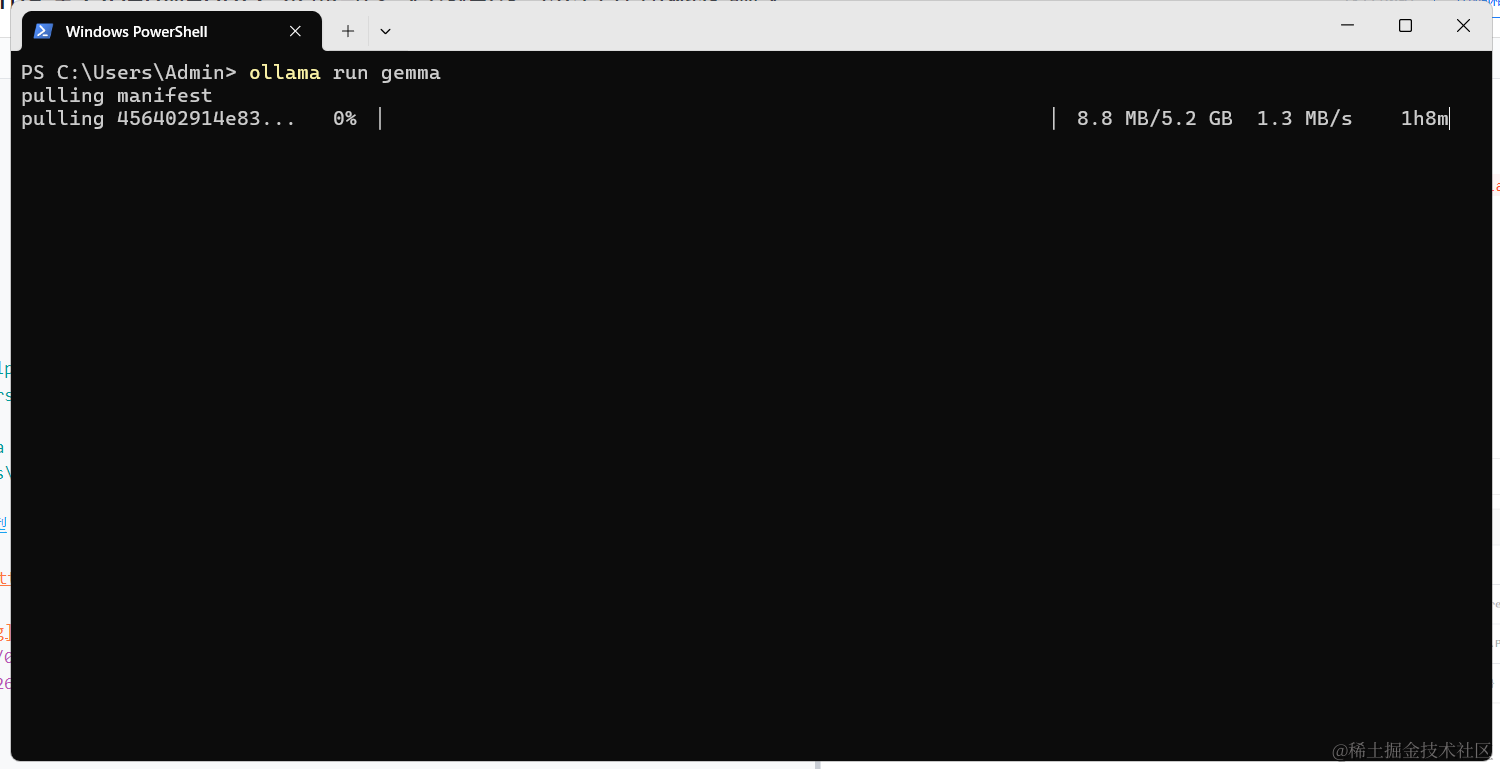

使用ollama

安装完成后,你可以通过命令行查看ollama的可用命令。例如,在windows的powershell中,输入ollama即可查看帮助信息和可用命令。

ps c:\users\admin> ollama

usage:

ollama [flags]

ollama [command]

available commands:

serve start ollama

create create a model from a modelfile

show show information for a model

run run a model

pull pull a model from a registry

push push a model to a registry

list list models

cp copy a model

rm remove a model

help help about any command

flags:

-h, --help help for ollama

-v, --version show version information

use "ollama [command] --help" for more information about a command.

ps c:\users\admin>

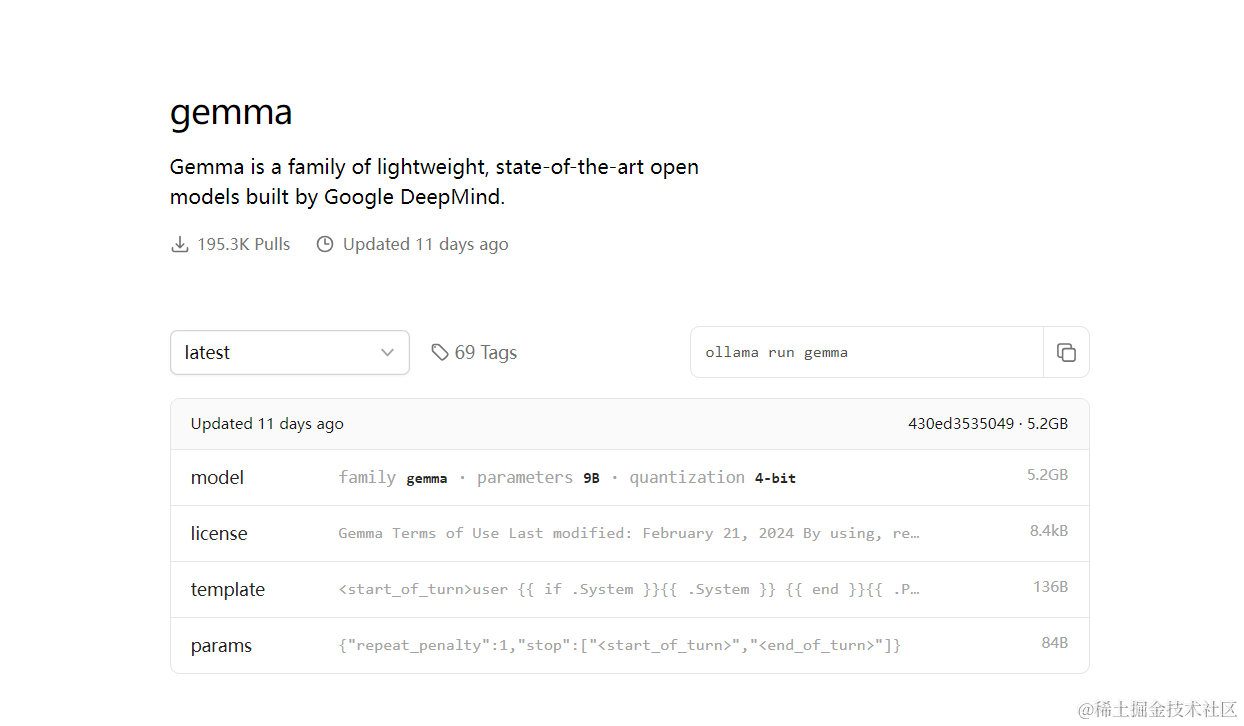

下载和使用大型模型

ollama的模型库提供了多种大型语言模型供用户选择。你可以通过访问ollama模型库来找到并下载你需要的模型。

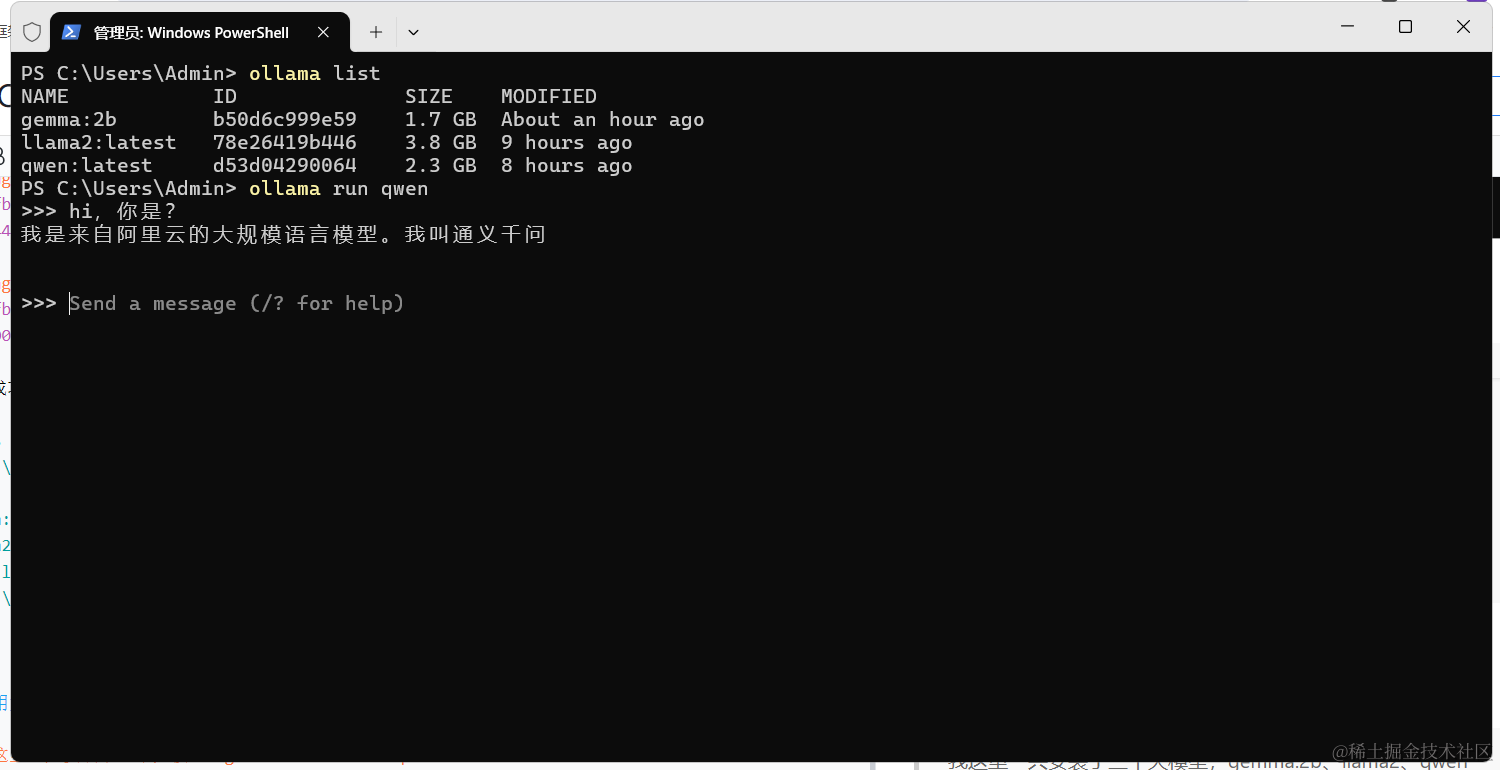

查看已安装模型

安装模型后,使用ollama list命令可以查看已安装的模型列表。

ps c:\users\admin> ollama list

name id size modified

gemma:2b b50d6c999e59 1.7 gb about an hour ago

llama2:latest 78e26419b446 3.8 gb 9 hours ago

qwen:latest d53d04290064 2.3 gb 8 hours ago

ps c:\users\admin>

运行模型

通过ollama run命令,你可以运行特定的模型。例如,ollama run qwen将启动qwen模型。

openwebui简介

openwebui是一个可扩展、功能丰富且用户友好的自托管webui,它支持完全离线操作,并兼容ollama和openai的api。这为用户提供了一个可视化的界面,使得与大型语言模型的交互更加直观和便捷。

安装 openwebui

- 如果您的计算机上有 ollama,请使用以下命令:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

- 如果 ollama 位于不同的服务器上,请使用以下命令:

- 要连接到另一台服务器上的 ollama,请将 更改

ollama_base_url为服务器的 url:

docker run -d -p 3000:8080 -e ollama_base_url=https://example.com -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

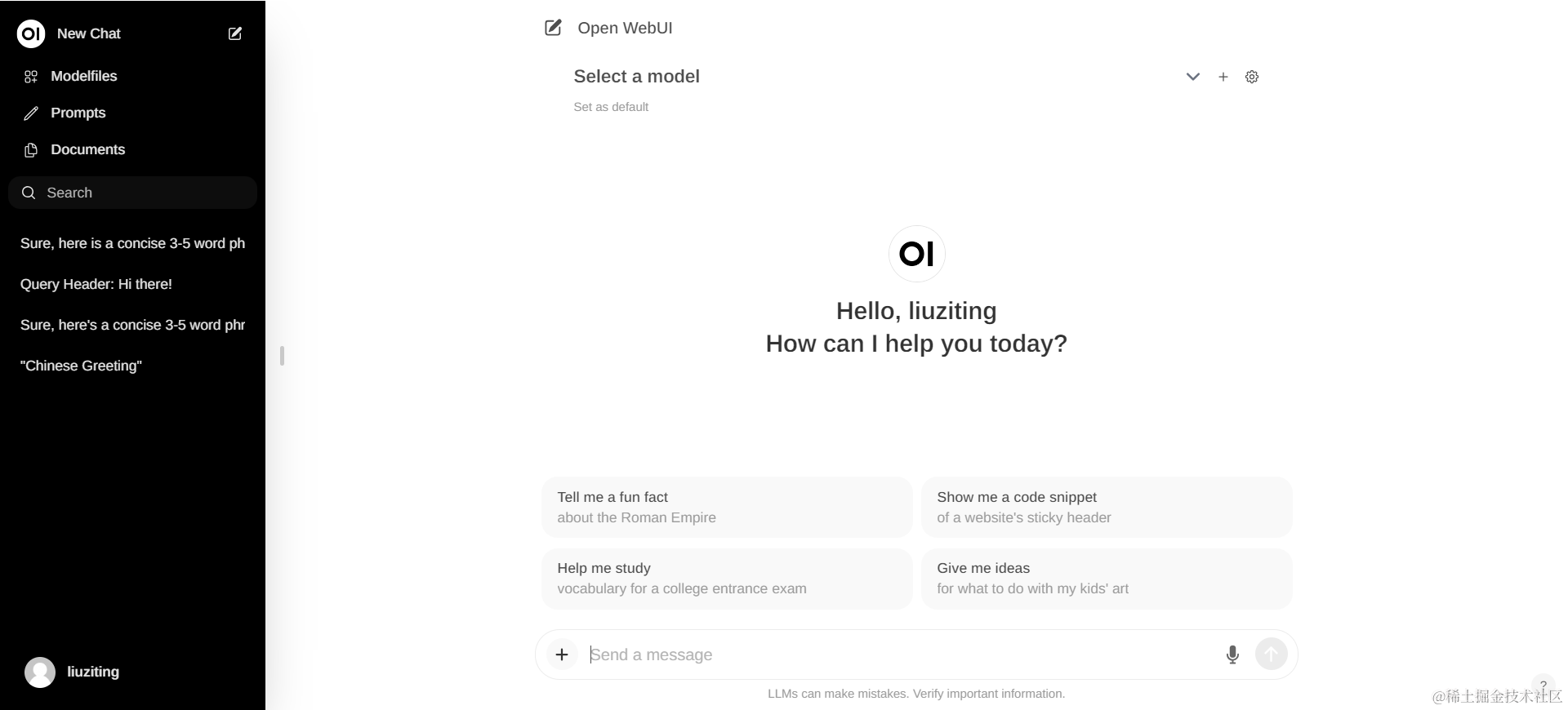

- 安装完成后,您可以通过http://localhost:3000 访问openwebui

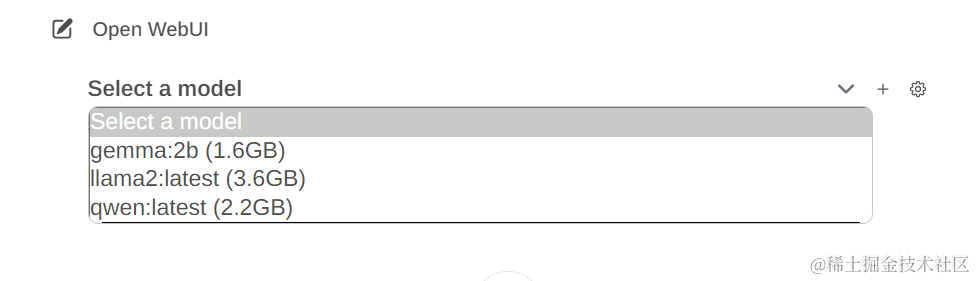

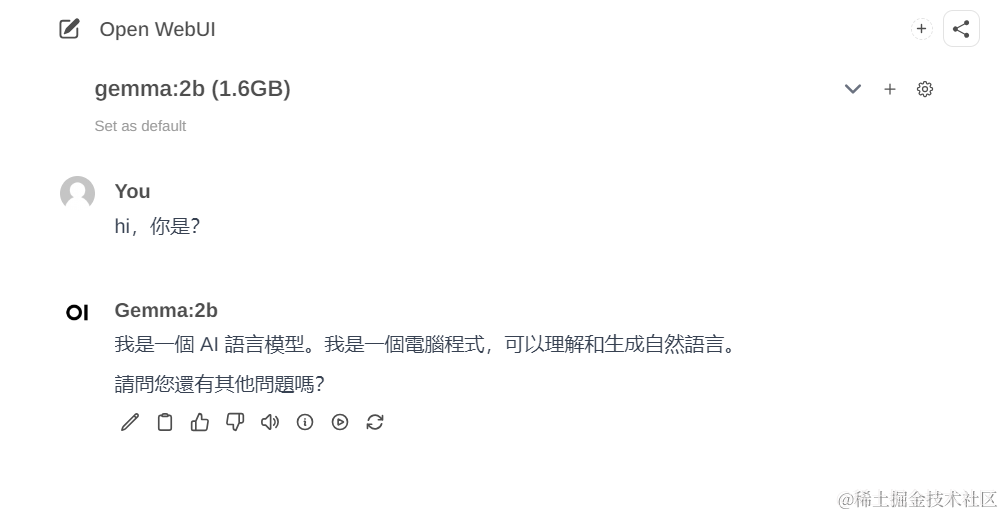

这个时候会发现【select a model】可以选择我们刚刚下载好的模型:

这样我们就有了一个类似gpt的可视化界面

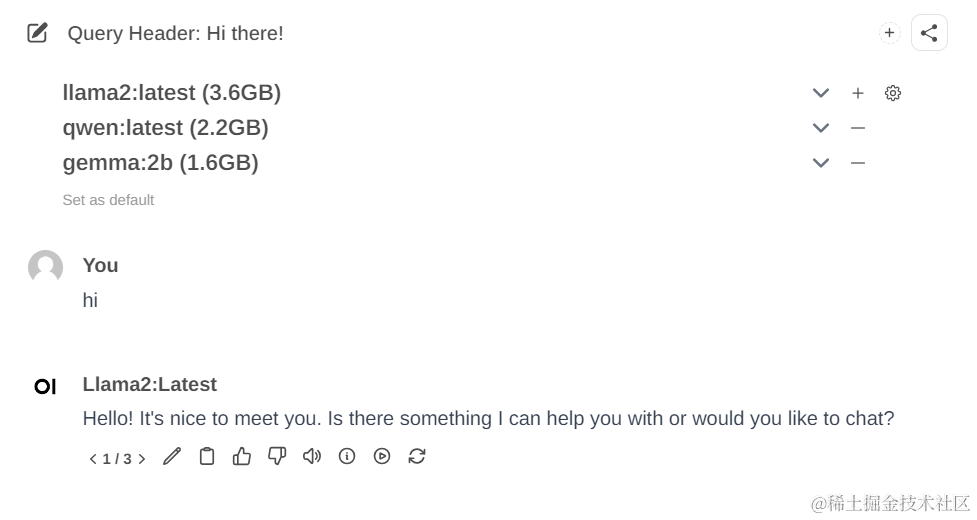

并且他还可以一次性加入多个模型,一起对话对比使用:

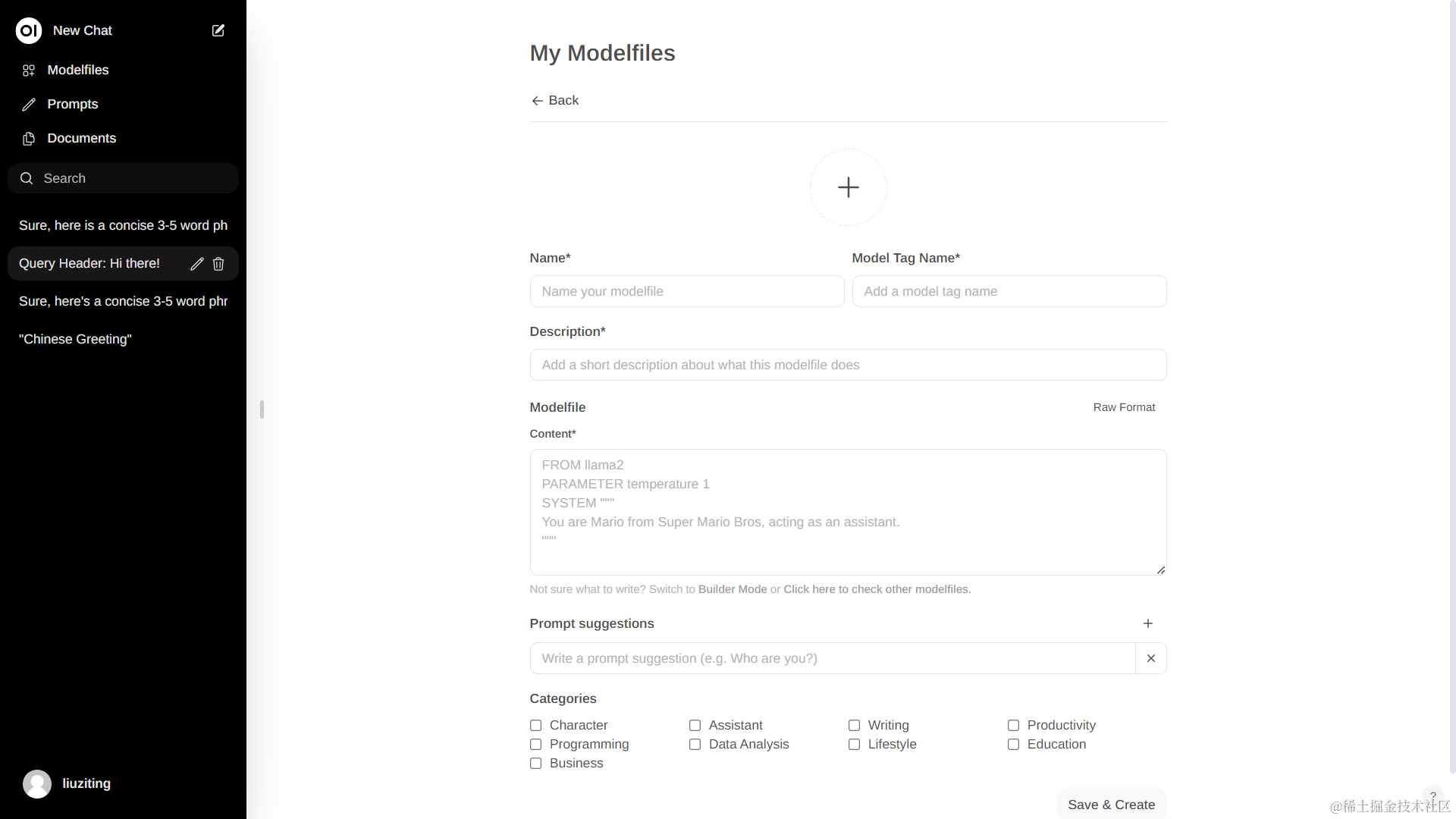

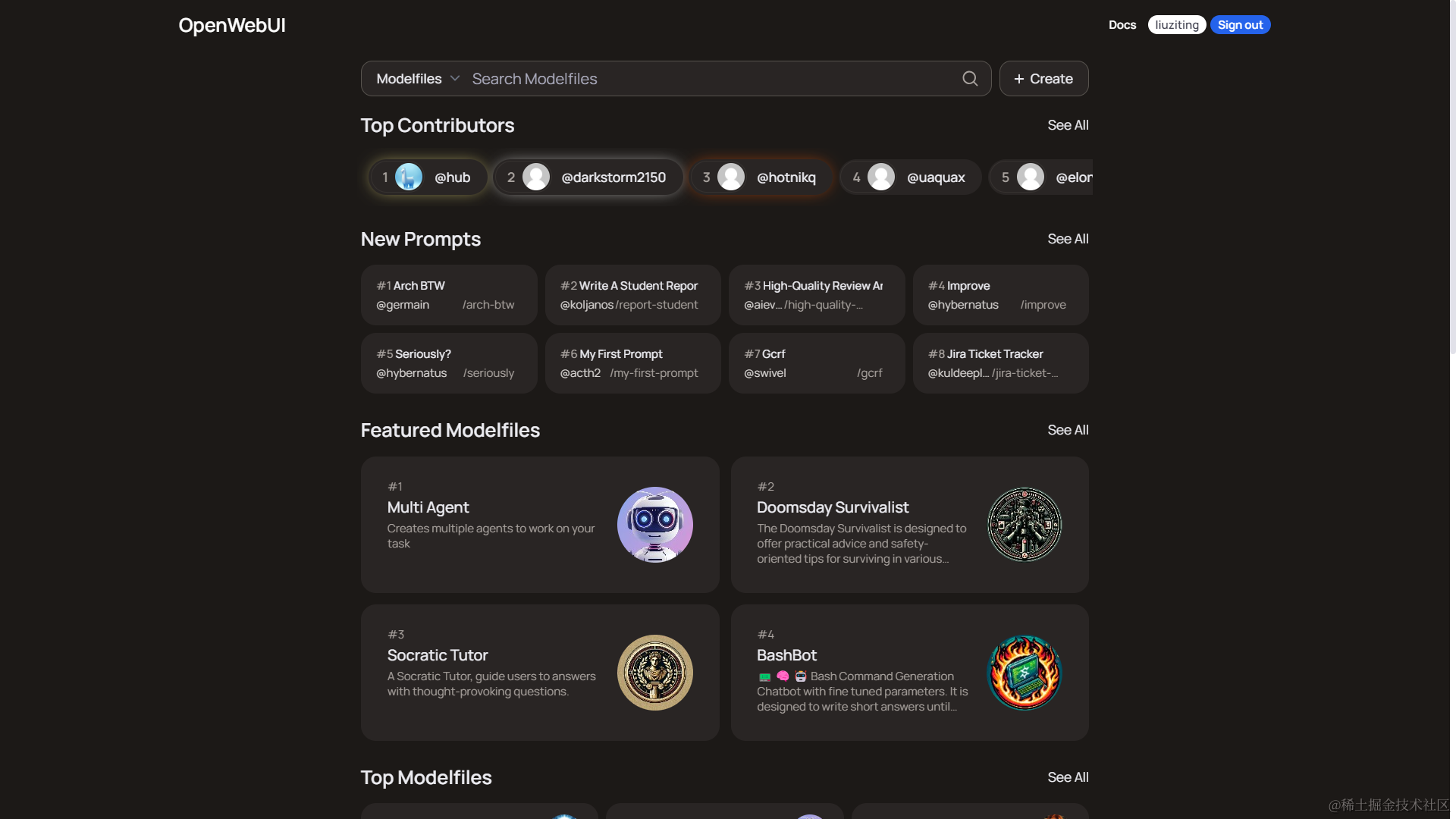

使用 modelfiles

可以自行按要求创建,也可去官网社区快速设置其他用户创建好的modelfiles。

您想发表意见!!点此发布评论

发表评论