深度长文 | 解析Apple Vision Pro 的3D功能与LiDAR工作场景,灵明光子ADS 6401 虚实交互的驱动引擎

347人参与 • 2024-08-06 • 交互

apple vision pro的传感器分布

apple vision pro目前公开出的产品形态包含众多传感器,以强化设备的深度信息感知能力,实现最佳的三维空间虚实结合效果。其中视觉传感器包括以下几类:rgb摄像头,红外摄像头,dtof激光雷达,结构光相机,以及鱼眼红外摄像头。

apple vision pro正面传感器分布图

(图片来自苹果公司官方公开信息)

apple vision pro 的外部包括以下几种视觉传感器

-

8 个摄像头

-

2个前向的rgb摄像头,支持前向拍摄和vst

-

4个向侧前方的鱼眼红外摄像头,支持6dof追踪

-

2个向下的红外摄像头,支持躯干追踪和下方的手势追踪

-

2个红外激光器,发出红外光对操控区域的躯干、腿部、膝盖、手以及环境进行照明,以辅助红外摄像头和鱼眼红外摄像头对相应区域内活动单元的捕捉

-

1 个dtof lidar激光雷达,沿用iphone pro后摄的dtof lidar形式,支持3d拍摄、空间重建、空间的深度感知与定位

-

1个结构光相机,与iphone的前置结构光face id类似,苹果公司称之为truedepth摄像头,支持facetime应用的面部扫描功能和前向区域的精细手势追踪

apple vision pro内侧传感器分布图

(图片来自苹果公司官方公开信息)

apple vision pro 的内部有 4 个红外摄像头和一圈 led,推测应该是采用结构光方案的光场信息进行眼动追踪和眼部表情分析。

苹果公司在apple vision pro上使用了丰富的传感器硬件,其中与其他vr厂商的尝试所明显不同的是,苹果公司使用了激光雷达lidar和结构光传感器,并取消了手柄而转用手势追踪来进行交互。这两者的结合,配合苹果公司优异的ui界面效果,实现了在同类硬件设备中非常突出的表现,让第一批apple vision pro的实机体验者们对其大部分功能给出了极高的评价。

apple dtof lidar的技术路线

苹果公司在其品牌下的系列产品上均使用了由索尼独家开发的dtof lidar激光雷达,并陆续搭载在ipad pro,iphone 12 pro,iphone 13 pro,iphone 14 pro,以及即将发行的apple vision pro产品上。在2013年苹果收购以色列3d传感公司primesense以及之后的一系列收购动作中,透露出苹果公司在进行消费电子产品上对3d功能的规划和长期布局。自2013年之后苹果公司进行了长时间的技术积累,聚焦在3d传感领域和dtof激光雷达方案上的成果最终于2017年和2020年陆续发布,包括2017年在iphone x上推出了前置结构光的face id功能,和2020年在ipad和iphone 12 pro上推出了与后置摄像头组合使用的dtof lidar激光雷达。

iphone 12 pro的lidar处于后摄模组的右下角

(图片来自苹果公司官方公开信息)

苹果和索尼合作的dtof lidar模组形态

(上图来自数码博主拆机视频,下图来自苹果公司官方公开信息)

从上图中可以看到,apple vision pro这款产品,其正中间的激光雷达的形态,与苹果公司前期发布的一系列产品所搭载的dtof lidar激光雷达模组几乎完全一致。据推测这款lidar使用的收光端spad面阵芯片方案为imx 590,是苹果公司与索尼的定制款芯片。但因为索尼近期的一系列商业动作,该型号未来可能会因为改版而发生一些变化,即整个dtof lidar的收发光核心芯片均有索尼独家提供。之前这款lidar所使用的发光端vcsel芯片,一直是由lumentum和win semi公司提供,而业内专家判断索尼希望将发光端vcsel芯片替换为索尼的自研芯片,索尼可能希望将vcsel和driver做成vcsel on driver的形式,以实现更优的性能和功耗。

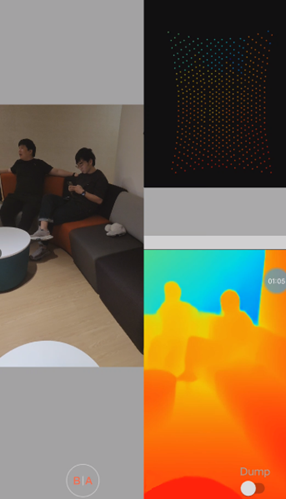

各种基于iphone所开发的3d应用

(根据自网络及苹果公司公开信息整理)

目前苹果公司在其高端机型上广泛使用的dtof激光雷达是由索尼独家设计并供应,其搭载的核心接收端芯片可能方案为imx590,是一款可以输出数百到上千个散点的spad面阵产品。苹果公司通过将这个传感芯片生成的散点阵列深度图像与主摄rgb图像进行融合,从而以算法实现较高分辨率及精度的mesh网格和rgbd融合深度图。第三方公司利用三维信息开发了各类3d应用及特效功能,包括知名的jigspace,roomplan,measure,polycam,3d scanner,canvas,playground ar,以及知名公司snapchat,ikea place的3d应用。

苹果公司iphone影像系统的isp架构

(根据苹果公司官方公开信息整理)

基于lidar的相关应用开发不仅只来自于第三方,苹果公司也在iphone的影像系统中不断基于lidar开发其isp图像处理框架。在2020年的iphone 12 pro加入dtof lidar之后,苹果公司在其isp图层处理中增加了“光分布图”,dtof lidar本身在测量深度的同时就可以获取红外光分布图,而且在2022年之后苹果将整套依靠光感与深度驱动的影像系统称为photonic engine(光子引擎),并将深度融合在图像处理过程中前置,置于3a层(自动曝光,自动白平衡,自动对焦)后的第一层,成为后续图层渲染等处理的重要依据。另外,3a层的自动对焦功能也是基于lidar的高帧率深度信息来实现的,lidar自动对焦可以极好地弥补摄像头pdaf在弱光、明暗交替等场景下较弱的自动对焦能力。

apple vision pro中展示的dtof lidar相关功能

苹果mr设备上所搭载的dtof lidar沿用了通过iphone所积累的三维重建能力,通过apple vision pro设备中间位置的lidar能够感知所处空间和房屋的3d空间结构,并将该空间结构运用到后面将介绍到的各类功能的方方面面之中。这个3d空间结构可以通过lidar预扫描建立而成,也可以通过高帧率的扫描来实时更新周边环境信息。

apple vision pro发布会3d空间重建

(图片来自苹果公司官方公开信息)

>>> vst功能 <<<

在展开apple vision pro的相关功能分析之前,我们需要先介绍vst(video see through 视频透视)技术。apple vision pro是一款mr(mixed reality 混合现实)设备,mr设备不同于vr(virtual reality 虚拟现实)和ar(augmented reality 增强现实)眼镜的地方是其可以实现vr的沉浸式体验,也可以实现类似于ar不摘掉头显设备直接看到外部世界的效果。ar设备是直接投过镜片看到真实世界,也称为ost(optical see through 光学透视)技术,通过特殊的透镜设计(如光波导镜片,birdbath等)将数字画面投射到半透明的显示装置上。

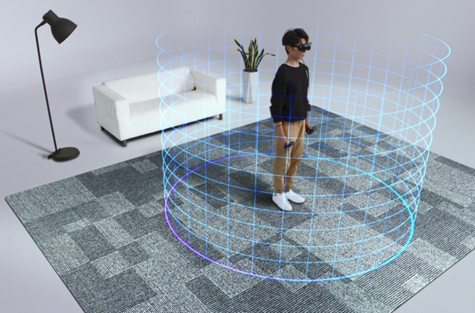

透过mr设备本身并不能看到外部环境,mr设备的形态与vr相似,但是mr设备具有vst功能,可以看到外部环境。目前市面上大部分vr设备也具备摄像头透视和安全边界功能,但基本上只提供非常低分辨率和低帧率的环境视频,当vr游戏用户离开初始位置太远且超出安全边界时游戏画面会消失,转而显示摄像头(或红外摄像头)拍摄的外部世界,通过该功能保护玩家使其留在安全边界之内。

vr设备的安全边界(图片来自网络公开信息)

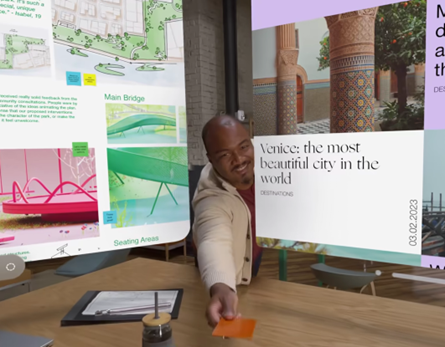

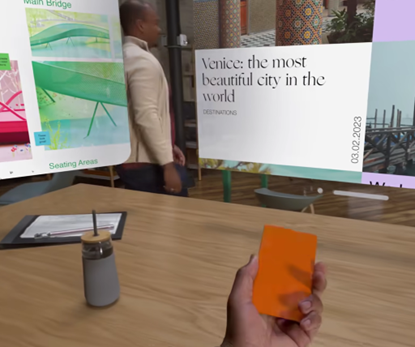

apple vision pro的显示示例:vst真实环境和虚拟界面与模型的叠加

(图片来自苹果公司官方公开信息)

apple vision pro是通过前向摄像头代替人眼对外部真实环境进行拍摄,再通过vst技术将拍摄的画面显示在左右眼两个显示区域。其在设备上方增加了实体旋钮来一键切换mr眼镜的工作模式,使用者可以通过物理旋钮来切换模式,选择是否看到外部环境。这里的外部真实环境(如上图背景中的工作室)是由vst拍摄的实时影像,而显示在空间中的虚拟界面和虚拟模型以及它们在桌面投射的阴影,都是通过visionos系统将虚拟图像融合在vst影像之中。也就是说,用户透过apple vision pro看到的内容,没有完全真实的外界,都是通过显示投射在用户眼中的。

为了实现vst和虚拟界面的最佳融合,虚拟阴影的最佳投射效果,需要由lidar提供外部真实环境的深度信息来实现最佳比例的透视关系。

apple vision pro保持交互感的vst与外屏

(图片来自苹果公司官方公开信息)

当然除了固定模式外,苹果公司也展示了自动结合vst和沉浸模式的功能,在有人接近的时候将人和其周边渐变地显示出来,并将自己的眼部图像显示在外界屏幕上,使得用户在佩戴头显设备的同时能与外界保持良好的交互感。

>>> 3d camera功能 <<<

apple vision pro记录的3d生活片段

(图片来自苹果公司官方公开信息)

3d camera是记录3d信息的视频,是一个让大多数体验者耳目一新的应用,留存人们珍贵的三维记忆,同时未来很可能对视频行业形成冲击与颠覆。其实现方法是类似观看3d电影的呈现方式,通过apple vision pro前部的两个rgb摄像头同时拍照或录制,在观看时再通过左右眼两个显示区域的分别显示,过程中不需要双目深度的参与,通过左右眼分别观看具有视差的两幅影像,使得观看者产生强烈的3d观感。

apple vision pro拍摄的3d影像是由左右眼从两个视频角度的观察并由大脑自然地进行图像融合,同时得益于头显设备极强的沉浸感而产生了非常优秀的3d效果,并非基于lidar或双目深度。但为了使得3d影像以合适的透视比例关系锚定在地面和桌面等场景上,3d camera需要配合lidar将影像投射在vst画面中,以产生最栩栩如生的场景还原。

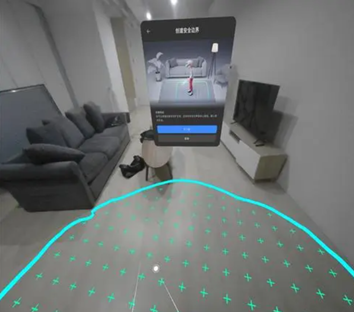

record3d的视频拍摄效果,rgbd融合示例

(上图根据网络公开信息整理,下图截取自灵明光子demo)

另外,基于dtof lidar的rgbd fusion数据本身也可以开发类似的3d应用,如在之前就有第三方公司开发过类似的应用record3d,通过lidar记录深度信息,iphone pro可以记录3d深度点云信息来合成3d视频。当结合photogrammetry算法和lidar深度后,可以直接扫描生成3d模型,例如polycam的相关应用。

>>> mindfulness功能 <<<

apple vision pro的沉浸冥想功能

(图片来自苹果公司官方公开信息)

mindfulness app可以创造空间感的视觉效果,让用户沉浸其中。该功能需要用到对房间的空间感知,来将特效融合在周边环境之中,以模拟真实环境中出现的虚拟特效,达到凭空出现特效来以假乱真的目的,利用特效的不真实感和vst的真实感之间的反差,让大脑认为vst的影像是真实环境。

vision pro的墙面投射功能,mesh算法示例

(上图来自苹果公司官方公开信息,下图截取自灵明光子demo)

用户可以将任何材质投屏到墙面、桌面、地面,例如将蓝天或星空投射到天花板。lidar的mesh功能帮助apple vision pro实现3d平面感知及锚定的功能,仅有双目视觉的硬件设备无法实现稳定和快速的平面锁定,因为在平面类的无纹理场景,摄像头的拍摄信息无法快速稳定地获取标志点,任何平面投射类的功能都需要lidar将虚拟信息稳定地贴附在平面表面。

>>> occlusion功能 <<<

occlusion前后遮挡功能

(图片来自苹果公司官方公开信息)

当用户处于vst模式时,apple vision pro所拍摄的周边环境需要和visionos系统本身的虚拟界面,形成合理的漂浮和遮挡(occlusion)关系。目前根据体验者的口述,在vst中显示的用户自己的手是通过抠图生成的,会有轻微的边界模糊和抖动感。而为了实现最佳的空间透视关系,需要将手、界面、vst环境、vst背景依次排序,并且保持相对关系的稳定和过渡衔接流程顺滑。

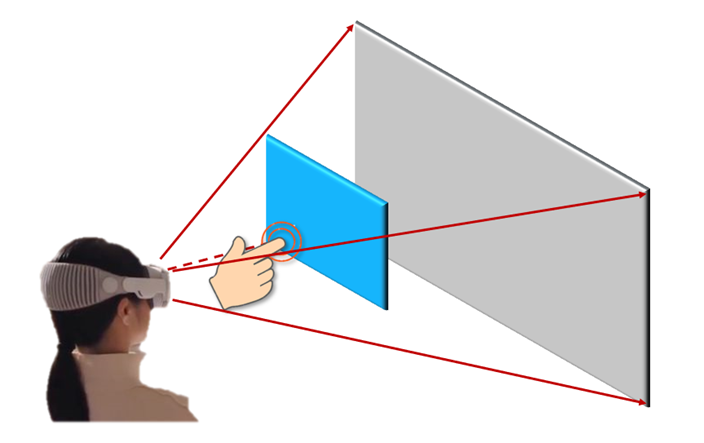

vst下显示的示例(图片来自绘制)

当使用mr眼镜时,用户的手处于最接近mr设备的位置,蓝色区域为虚拟界面,灰色区域为由vst所拍摄的外部真实环境(并非3d物理空间,而是两幅画面的拼接,由人眼和人脑系统自动生成融合后的画面)。为了使得各个层面之间的相对位置关系正确,手能够正确地出现在蓝色区域的前方,需要由lidar参与遮挡关系的形成。一种途径是dtof lidar和rgb摄像头形成rgbd fusion的稠密点云深度图,来确认空间物体的相对位置关系;另一种途径是由lidar和两个前置摄像头共同完成整个3d空间的重构,使得vst中显示的物体本身具备3d关系(或简单看做将场景中的各类物体分割出前后和上下图层的关系),类似于roomplan标记空间内物体的边线和面,通过立方体代表每个物体的空间体积和位置关系。仅由摄像头生成的vst画面和手部抠图显示出的用户的手,在人脑判断过程中可以看出所呈现的并不是最完美的occlusion效果。

手部的捕捉和追踪在红外摄像头的全景范围内都可以实现,并不是只在结构光相机的视场区域。我们预测在结构光的区域内会有一些用户自定义的精细手势,但整体的手势追踪由红外摄像头完成,遮挡关系的建立由lidar完成,多个传感器之间会有精细的融合逻辑。

3d视觉的产生及其与mr应用的关联

为什么众多业内人士和科技行业从业者,在体验过apple vision pro后得到了很好的3d视觉体验,产生这个体验的底层原理是什么,为什么我们的大脑和双眼会通过这种方式来协同工作而不是其他的方式?我们可以从哺乳动物的进化来理解这个结果,因为动物的全景视觉是一种防守型的视觉策略,而双目视觉属于攻击型策略。自然界中,食草动物偶蹄类的眼睛是对称开放式的,视场角fov非常大,接近360度,可以在吃草时从任何方向发现靠近自己的捕食者。然而捕食者如狮虎狼豹等进化出的是双目视觉,通过基线和双目视差来判断自己和猎物之间的距离关系,从而判断发起攻击的时机。

>>> 3d视觉的来源 <<<

那么双目视差为什么能让我们看到立体的物体,3d感是来自哪里?这里包括心理感知和生理感知两个层面。

在心理感知层面,人类会因为仿射、阴影、遮挡、纹理、先验知识等的视觉暗示判断2d的图像具有3d的效果。

-

仿射:即“近大远小”透视,成像的过程是物体离人眼越近在人眼中的成像就越大

-

阴影:自然环境中光照来自不同方向,在物体表面光照会产生不同的高光和阴影效果,我们通过对阴影的推理来判断物体的三维形状

-

遮挡:近的物体会遮挡住远的物体,通过互相遮挡关系可以判断物体间的远近差异

-

纹理:因为纹理有着动静规律而高度重复的特征,从而产生了立体视觉感

-

先验知识:在大量的经验总结之后,大脑会对物体与场景进行归纳,来通过常识判断物体的实际大小和远近

在生理感知层面,立体视觉的形成主要包括双目视差、移动视差、聚焦模糊。

-

双目视差(binocular parallax)

当我们左右眼看同一个物体时,通过左右眼获取同一个物体不同的图像,在各自视网膜上形成该物体的两个像,然后分别经两侧视神经传到皮层视中枢的同一区域。这两张画面会被大脑所融合(fusion),融合过程存在着复杂的视觉神经网络的仿射和处理过程,而融合成为完整、单一的物象。最终由大脑通过图像间存在的立体视差(stereopsis)来判断物体距离,一般而言,当两个视野上具有相近或相关的图形、明度或颜色的物象时,容易发生双眼视象融合。否则为双眼竞争,可见双眼播放不同画面的一些医学研究案例,这里就不再赘述。

-

移动视差(motion parallax)

当距离观察者不同的物体在运动时,位移距离在观察者眼中是不同的。对于相同的位移距离,近处的物体位移大,远处的物体位移小,我们常见的鸽子就是通过这种位移的方法不断移动头的位置,产生移动视差,来观察地面的物体。相比3d影院,mr头显设备可以提供移动视差,从而提供真实的沉浸感。

-

聚焦模糊(accommodation)

人眼的睫状肌具有相机镜头的调焦功能,通常我们人眼观察的位置是对焦的,而焦外是模糊和虚化的,这是因为人眼的生物结构形成了这样的结果,大脑也长期以来适应这样的过程。

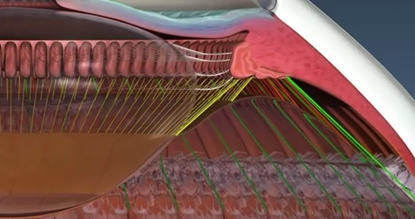

>>> 晶状体的工作机制 <<<

当睫状肌向内收缩时,睫状小带松弛,晶状体厚度增加(变凸),前后的曲率增加。这个过程中,就是下图的上方形态变成下方形态的过程,左边的透明球体为晶状体,右侧的粉红色和上方的粉蓝色区域为睫状肌,黄色和绿色的细线是睫状小带,睫状肌和睫状小带共同牵引晶状体。

眼睛晶状体的侧面结构图

(图片来自网络公开信息)

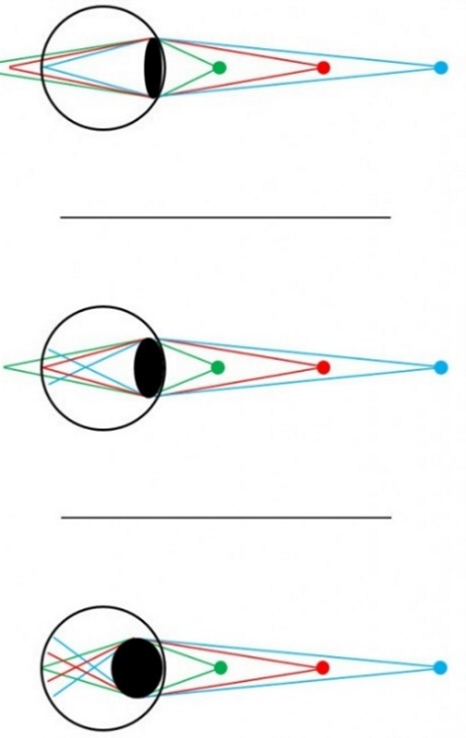

当睫状肌改变时,晶状体被挤压或拉伸,从而改变了人眼对焦的距离。不同距离的对焦过程如下图所示,当晶状体较薄时,远处的蓝色光线聚焦在视网膜上,人眼看蓝色清楚,红色和绿色自然模糊。当晶状体较厚时,近处的绿色光线聚焦在视网膜上,人眼看绿色清楚,蓝色和红色自然模糊。这也是为什么人眼需要在近距离使用一段时间之后,做一些远眺和放松,来恢复睫状肌和晶状体的疲劳与紧张状态,否则睫状肌的长期紧绷会挤压眼球变凸,导致晶状体无法清晰聚焦远处的光线(蓝色),从而导致眼突和视力变差。

晶状体在不同厚度下,将不同距离的光线聚焦在视网膜上

(图片来自网络公开信息)

>>> mr设备如何重塑3d自然视觉 <<<

了解了3d视觉的来源,下面我们来看一下近场的显示设备是如何改变人类在真实环境中自然的3d视觉,以及为什么有的头显设备会使人产生不适感,使用lidar如何帮助减少这类不适感。

假设有一个非常优秀的显示设备,所投射的所有影像都非常真实,并且我们在影像中移动也无法感到不真实感,那么这个设备不会对我们的3d视觉产生任何影响,甚至我们会误认为这就是真实的现实。目前的头显设备就是因为难以满足这些特点,导致人脑会产生判断混乱,而产生不适感。

首先我们来了解大脑的原理,大脑主要依靠视觉、前庭、身体感知这三条途径来综合判断人体的位置、姿态与运动状态。

-

视觉:视觉能直接观察身体所处的三维环境,大脑会通过自身和环境的相对位置信息,推断出自身目前的运动状态,类似于3d slam的工作原理。

-

前庭:人耳的前庭内有三个相互连通的半规管,管内含有淋巴液,是脊椎动物内耳迷路中掌管平衡感的器官。这三个半规管,就类似于一个无穷多轴的imu,人体运动时,大脑就会通过半规管推断出目前的姿态和运动加速度。

-

身体感知:身体感知是身体肢体对运动过程的直接感知,肢体相当于具备多轴、加速度计、力传感器、触觉传感器等复杂运动神经和感觉神经系统的实体,神经系统将肢体的感知反馈给大脑,大脑通过大脑皮层、基底节和小脑等多个区域协同完成对肢体的控制。

因为大脑是依靠视觉、前庭、身体感知这三条判断依据来确定真实感,那么我们来分析一下引起3d眩晕的两个主要原因:

-

大脑和身体的判断相冲突

-

当身体和vr眼镜显示的画面不同步、不及时、不准确时,会导致视觉和身体感知的冲突:比如,进行vr游戏时出现“身体移动,画面不变”,这种情况下前庭和身体感知已变化,但视觉未变化;或“身体不动,画面变动”,这种情况下前庭和身体感知无变化,但视觉发生变化;或各种组合情况的不断重复发生。这些情况会导致大脑产生疑惑和判断紊乱,容易出现视眩晕、紧张、疲劳、头痛等不良反应。

-

因为显示屏刷新率,渲染和定位的速度精度等技术的限制,显示端无法给眼睛投射最拟真的图像。目前随着apple vision pro设备在这些方面的提升,以及精细的ui界面交互感,使得引起眩晕的原因得到大幅缓解。在其他vr场景下,依靠万向跑步机和体感机,也可以模拟出更真实的脑身一体感。

-

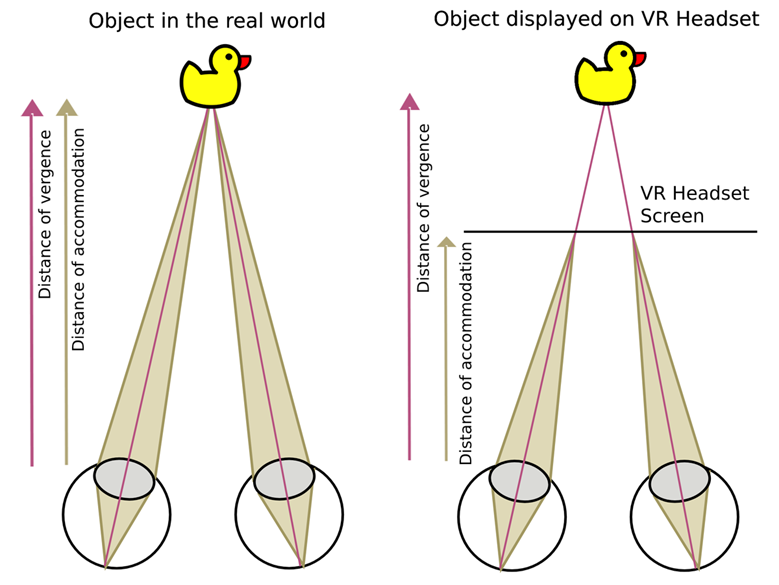

vac现象(vergence-accommodation conflict辐辏调节冲突)

-

视觉感知中双目视差与聚焦模糊之间出现了冲突,这方面原因引起的3d眩晕也是一个重要影响因素。

-

mr设备的佩戴者的视点始终聚焦在一个固定距离的虚拟屏幕上,不能随着显示的虚拟物体的远近而重聚焦(refocus),通过设备的显示屏观察远处的景象时,人眼通过双目视差感知到高山很远,但accommodation下人眼并没有实际聚焦到那么远;观察近处的物体时,眼睛仍然聚焦在屏幕上,这与双目视差所呈现的实际距离产生了偏差,从而导致大脑产生深度感知冲突,进而引起视觉疲劳。

vergence和accommodation距离的差异

(引用自维基百科)

vergence辐辏:上图红线,两只眼睛朝内(所视物体靠近)或朝外(所视物体远离)转动,双眼的视线相交于同一深度的点。accommodation调节聚焦:上图黄线,两只眼睛看到的分别处于屏幕上的不同位置。

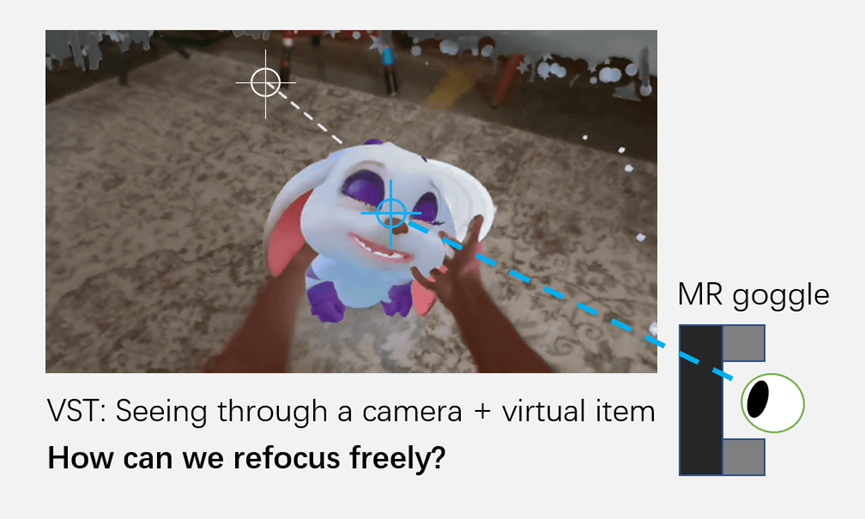

由于这两方面的影响,大脑和体感,大脑和眼睛,三者之间的相互冲突导致人们在佩戴头显设备时会自然地感到不适,尤其是在佩戴初期阶段。而lidar是如何参与并影响vst,来降低vac现象的呢?首先lidar会对vst视野中被视的物体区域所有的物体进行扫描,实时高帧率地获得所视范围内各个物体的距离信息,不论是人眼对焦的物体,或是焦外的物体。

通过mr眼镜做vst重对焦的示意图(图片来自绘制)

如上图所示vst中,在用户视野的瞬时转换时,显示设备需要模拟真实环境中人眼的重对焦过程,即由原来的蓝圈位置对焦瞬时切换到白圈位置对焦。这个过程中,除了内侧设备的人眼跟踪功能以外,还需要对外界信息进行符合规律的模糊和虚化,这个规律跟外界物体与观察者的位置相关,也就是和lidar所实时测量的环境实时深度信息相关。如果仅仅依靠算法计算,对焦外区域进行特定规则的均匀模糊和虚化,则无法模拟每个物体在真实空间最拟真的虚化状态,使得大脑产生不真实感。

灵明光子ads 6401技术及功能详解

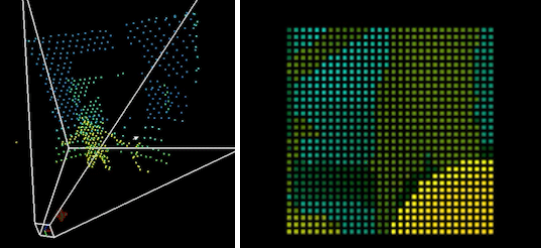

灵明光子的ads6401产品,是dtof lidar的接收端芯片,接收端芯片的性能基本上定义了整个激光雷达系统的功能上限。ads6401实现了对iphone lidar scanner的超越替换,不仅在分辨率上具备比其576个散点更高的“960点的散点输出”,在功能性上更有可实现远高于其30fps工作帧率的“4分区分时曝光的120/240 fps设计”。

ads6401感光区尺寸为1/6.76,对角线长度为2.6mm,实现有效像素210x160共33600个spad像素,像素尺寸10μm,芯片总面积为3.6 x3.4mm。有效深度输出为240个点/分区,4分区整合下为960个点;芯片支持灰度图和深度图两种方式输出,pde@940nm14~20%,测距范围支持0-19m。带有片上温度检测和电压检测;芯片通过片上驱动信号,可以输出高频脉冲驱动外部driver,波形可调控;可在主/从两种模式下,利用vsync信号和rgb摄像头同步;

ads6401可以匹配多种发光端光学设计,支持点线面等不同的发光模式,在低功耗情况下呈现出色的测距性能。以约500点的散点投射的参考设计方案为例,在0.15m-6m测距距离内的芯片功耗约为80mw,整体系统功耗约为230mw(30fps下,包含芯片功耗,发射端功耗,以及用户soc上进行深度计算功耗);在0.15-6m范围内的近距离测量精度达到了5mm,远距离下精度小于1cm;在8m下的精度可达到1cm即0.125%,最远测距可配置到19m。灵明光子通过优异的系统方案设计,使得ads6401在室内外均表现出优异的性能,在室外工况下达到了50klux下测距6m的抗阳光水平。

ads6401芯片的输出数据为统计直方图形式,配合客户的主控芯片进行计算深度,相比于片上直出深度的模式,能够开放更全面的测距功能。通过客户自定义的统计直方图数据处理方式,可以攻克dtof技术中的一些关键难点,包括盖板串光致盲和pile-up等现象,满足客户对于近距离盲区、测距精度、鲁棒性的基础要求;支持在soc上做测距置信度的计算和多峰检测等高级信号处理功能;满足客户实现点云滤波、抗玻璃干扰(玻璃检测)、消除多路径干扰等高级需求。并且,统计直方图数据能够供研究者和开发者进行创新应用的开发,包括利用直方图信号对测距滤波,环境光信号分析,以及在医学和医疗方面的荧光寿命测量。soc侧的算力消耗在30fps下约为0.5gops,适用于cpu、dsp、npu等多种计算架构,灵明光子可以提供相应的计算加速参考代码。

ads6401芯片具备高效的多区控制和多区数据直出能力,可以利用4分区实现 120/240 fps的超高子画幅帧率,为高速影像和ar交互提供支持。同时,通过配合分区/单区不同类型的激光驱动模式,可以实现分区/单区的分别工作调用,在此基础上能够进一步降低全画幅的分辨率要求,最终实现整体系统功耗的进一步降低,将发射端和接收端的总功耗控制在100mw以下。

ads6401显著增强摄像头的工作能力,实现自动对焦、电影模式、夜景人像、图像处理等高级影像效果;完善了暗光环境中的自动对焦,为短视频拍摄提供“一镜到底”的效果;能做到在多个摄像头之间的无缝线性切换,视场角可在66x54度范围内覆盖;结合rgb的信息可以进行rgbd深度融合,具备生成丰富的焦外虚化和多样的背景特效处理的能力。

灵明光子adaps已与高通qualcomm和虹软arcsoft公司合作,通过ads6401实现了安卓阵营全球首款的dtof电影模式,并于2022年11月16日在三亚的高通年度骁龙技术峰会上进行了实机展示,搭载ads6401的高通qrd手机实现了惊艳的手机电影模式效果。

灵明光子面阵产品系列

单光子雪崩二极管spad(single photon avalanche diode)是支持dtof(direct time-of-flight,直接飞行时间深度测量)技术的最前沿感知器件。通过结合spad器件与逻辑电路,类似ads6401的散点面阵类芯片可以计算脉冲光从发射到返回的飞行时间来获取距离信息,实现了极低功耗、极高精准度、高帧率下的实时三维测量。dtof传感器可以和rgb摄像头结合,实现相辅相成的完美互补,将点云图从稀疏到稠密的多种类型完全覆盖,从而实现了对各类人体姿态和手势运动的捕捉与追踪。也可以结合imu,搭建slam和3d mesh功能,有利于xr头显设备实现极致的虚实交互功能。同时,灵明光子已开发完善了算法体系,提供基础的rgbd融合、平面检测、手势识别等算法的基础原型,供客户进行二次开发。

除了散点形态的产品以外,灵明光子目前正在开发各种面阵型的产品,用于多种3d传感和激光雷达产品中,欢迎垂询。

* 关于苹果公司和索尼公司的信息均整理自公开信息渠道

您想发表意见!!点此发布评论

![[3D Selection]AR/VR/MR虚拟现实环境中的3D场景物体交互方法调研](https://images.3wcode.com/3wcode/20240806/s_0_202408061152506283.png)

发表评论