腾讯云TStor存储一体机在大模型场景下的业务实践

74人参与 • 2024-08-06 • 网络协议

引言

近年来,随着chatgpt的发布,掀起了一股生成式ai(aigc)的热潮。从今年开始,国内各家企业也纷纷发布了自家的大模型产品,5月科技部下属的中国科学技术信息研究所发布了《中国人工智能大模型地图研究报告》。报告显示,截至5月28日,国内10亿级参数规模以上基础大模型至少已发布79个。衡量大模型产品能力的一个很重要的指标就是参数量,从10亿级、百亿级到现在的千亿级。参数量的快速增长,对支撑ai训练的基础设施,如计算、网络、存储等也提出了更高的要求。存储作为it基础设施的重要组成部分,在扩展性、高性能和多协议接口等方面,也需要与时俱进。腾讯公司推出的tstor存储一体机正是这样一款存储产品,本文将基于大模型场景对存储的挑战,介绍tstor在该场景的优势,以及在某大模型产品中的业务实践,供广大希望自建大模型应用的企业参考。

ai大模型场景对存储的关键需求

在ai大模型场景下,对存储系统提出了几个关键需求:

1. 大容量

ai大模型需要处理和存储海量的训练数据和中间结果,一般数据量在pb级甚至eb级。因此,存储系统需要具备高可扩展性,以满足这些大规模数据的存储需求。tstor存储一体机基于分布式架构,最小规模三节点起步,支持横向扩展,满足了ai大模型场景海量数据存取需求。

2. 高性能

ai大模型的训练和推理过程对存储系统的读写性能要求非常高,特别是在数据集读取和checkpoint的读写,需要高带宽的数据传输和低延迟的响应。因此,存储系统需要具备高性能的特点,以保证ai大模型的高效运行。tstor存储一体机,结合腾讯云自研的星星海服务器,搭载高性能nvme闪存盘,可提供数百gb/s的带宽,大幅缩短数据读写时间,提升整体训练效率。

3. 多协议接口

ai训练的数据来源多种多样,涉及到多种数据类型和格式,不同的应用对于存储接口的需求也不一样。因此,需要存储系统具备多协议接口的特点,以便支持不同类型的数据存储和访问。tstor存储一体机支持主流的文件(nfs、cifs、ftp等)、块、对象(s3)等存储接口,方便对接不同上层应用,满足复杂文件类型的存储需求,为ai训练数据的归集和清洗提供高效的存储平台。

tstor存储一体机在大模型场景下的实践

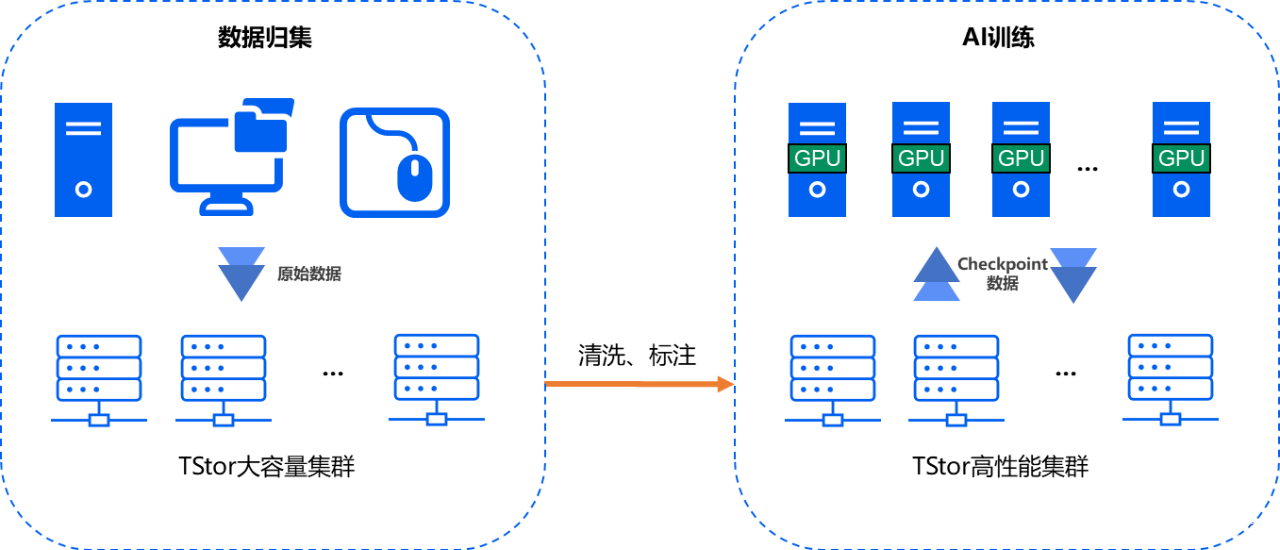

某企业自建了一套aigc大模型训练集群,原始的训练数据多达数十pb,清洗后用于训练的数据有数个pb,模型参数量高达千亿级。该企业选择了tstor存储一体机,用于满足该场景下苛刻的存储需求。方案整体架构如下图所示:

在训练数据的归集阶段,tstor基于大容量低成本的hdd硬盘,搭建了一套存储集群,用于海量原始训练数据的集中存储。每个数据节点配置了60块20tb硬盘,单节点的原始容量高达1.2pb。底层数据冗余使用了具备更高容量利用率的纠删码算法,进一步降低了数据存储的成本。该集群对外提供文件和对象存储接口,对接了企业内的十多个业务数据源。同时,我们还启用了数据的生命周期管理功能,将近期不再使用的冷数据沉降到了更低存储成本的介质上长期归档保存。

原始训练数据经过清洗、标记等处理后,保存在另一套tstor集群中,用于模型训练。在训练数据的加载阶段,从该集群读取数据。另外,在训练过程中,每隔一段时间,会将checkpoint数据写入该集群。为了满足训练阶段的高性能需求,我们基于全nvme闪存配置的机器,搭建了这套tstor集群。每个节点配置了24块7.68tb的nvme闪存,配备100ge网卡来消除网络瓶颈,整个集群规模在数十个节点,有效容量达到数个pb。在集群运行过程中,我们观察到数据读写带宽达到数百gb/s。在如此高的负载下,tstor存储集群仍然能够长期稳定运行,有效提升了大模型训练的效率,缩短了训练时间。

实践证明,tstor存储一体机完全能够胜任aigc大模型场景对存储的苛刻要求。如果您有自建大模型训练集群的需求,欢迎公众号留言与我们联系,我们将致力于为您提供最优的aigc大模型训练存储解决方案。

微信扫一扫

微信扫一扫

您想发表意见!!点此发布评论

发表评论