Nginx反向代理和负载均衡详细教程

85人参与 • 2024-08-06 • 网络协议

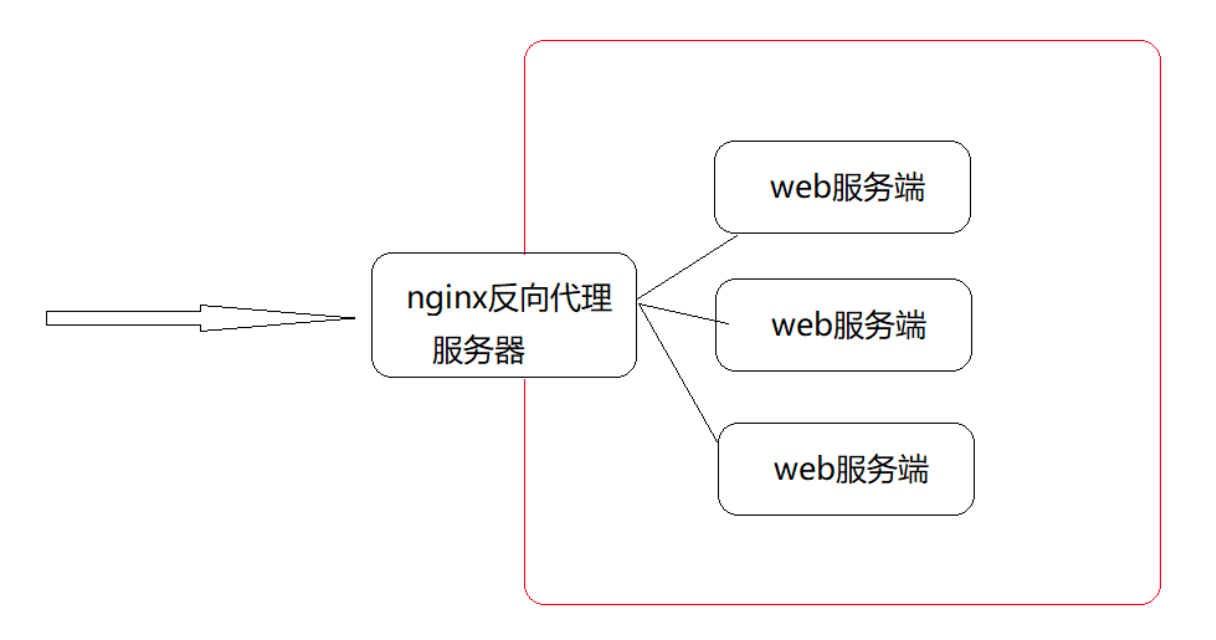

1、nginx反向代理概述

先提需求:

(1)服务端的设置:

http {

log_format main 'client send request=>clientip=$remote_addr serverip=>$host';

server{

listen 80;

server_name localhost;

access_log logs/access.log main;

location {

root html;

index index.html index.htm;

}

}

}(2)使用客户端访问服务端,打开日志查看结果

(3)代理服务器设置:

server {

listen 82;

resolver 8.8.8.8;

location /{

proxy_pass http://$host$request_uri;

}

}(4)查看代理服务器的ip(192.168.200.146)和nginx配置监听的端口(82)

(5)在客户端配置代理服务器

(6)设置完成后,再次通过浏览器访问服务端

通过对比,上下两次的日志记录,会发现虽然我们是客户端访问服务端,但是如何使用了代理,那么服务端能看到的只是代理发送过去的请求,这样的化,就使用nginx实现了正向代理的设置。

但是nginx正向代理,在实际的应用中不是特别多,所以我们简单了解下,接下来我们继续学习nginx的反向代理,这是nginx比较重要的一个功能。

1.1、nginx反向代理的配置语法

nginx反向代理模块的指令是由ngx_http_proxy_module模块进行解析,该模块在安装nginx的时候已经自己加装到nginx中了,接下来我们把反向代理中的常用指令一一介绍下:

proxy_pass

proxy_set_header

proxy_redirectproxy_pass

该指令用来设置被代理服务器地址,可以是主机名称、ip地址加端口号形式。

| 语法 | proxy_pass url; |

| 默认值 | — |

| 位置 | location |

举例:

proxy_pass http://www.baidu.com;

location /server{}

proxy_pass http://192.168.200.146;

http://192.168.200.146/server/index.html

proxy_pass http://192.168.200.146/;

http://192.168.200.146/index.html大家在编写proxy_pass的时候,后面的值要不要加"/"?

接下来通过例子来说明刚才我们提到的问题:

server {

listen 80;

server_name localhost;

location /{

#proxy_pass http://192.168.200.146;

proxy_pass http://192.168.200.146/;

}

}

当客户端访问 http://localhost/index.html,效果是一样的

server{

listen 80;

server_name localhost;

location /server{

#proxy_pass http://192.168.200.146;

proxy_pass http://192.168.200.146/;

}

}

当客户端访问 http://localhost/server/index.html

这个时候,第一个proxy_pass就变成了http://localhost/server/index.html

第二个proxy_pass就变成了http://localhost/index.html效果就不一样了。proxy_set_header

| 语法 | proxy_set_header field value; |

| 默认值 | proxy_set_header host $proxy_host;proxy_set_header connection close; |

| 位置 | http、server、location |

需要注意的是,如果想要看到结果,必须在被代理的服务器上来获取添加的头信息。

被代理服务器: [192.168.200.146]

server {

listen 8080;

server_name localhost;

default_type text/plain;

return 200 $http_username;

}代理服务器: [192.168.200.133]

server {

listen 8080;

server_name localhost;

location /server {

proxy_pass http://192.168.200.146:8080/;

proxy_set_header username tom;

}

}访问测试

proxy_redirect

该指令是用来重置头信息中的"location"和"refresh"的值。

| 语法 | proxy_redirect redirect replacement;proxy_redirect default;proxy_redirect off; |

| 默认值 | proxy_redirect default; |

| 位置 | http、server、location |

为什么要用该指令?

服务端[192.168.200.146]

server {

listen 8081;

server_name localhost;

if (!-f $request_filename){

return 302 http://192.168.200.146;

}

}代理服务端[192.168.200.133]

server {

listen 8081;

server_name localhost;

location / {

proxy_pass http://192.168.200.146:8081/;

proxy_redirect http://192.168.200.146 http://192.168.200.133;

}

}该指令的几组选项

proxy_redirect redirect replacement;

redirect:目标,location的值

replacement:要替换的值proxy_redirect default;

default;

将location块的uri变量作为replacement,

将proxy_pass变量作为redirect进行替换proxy_redirect off;

关闭proxy_redirect的功能

1.2、nginx反向代理实战

服务器1,2,3存在两种情况

第一种情况: 三台服务器的内容不一样。

第二种情况: 三台服务器的内容是一样。- 如果服务器1、服务器2和服务器3的内容不一样,那我们可以根据用户请求来分发到不同的服务器。

代理服务器

server {

listen 8082;

server_name localhost;

location /server1 {

proxy_pass http://192.168.200.146:9001/;

}

location /server2 {

proxy_pass http://192.168.200.146:9002/;

}

location /server3 {

proxy_pass http://192.168.200.146:9003/;

}

}

服务端

server1

server {

listen 9001;

server_name localhost;

default_type text/html;

return 200 '<h1>192.168.200.146:9001</h1>'

}

server2

server {

listen 9002;

server_name localhost;

default_type text/html;

return 200 '<h1>192.168.200.146:9002</h1>'

}

server3

server {

listen 9003;

server_name localhost;

default_type text/html;

return 200 '<h1>192.168.200.146:9003</h1>'

}- 如果服务器1、服务器2和服务器3的内容是一样的,该如何处理?

1.3、nginx的安全控制

安全隔离

什么是安全隔离?

1.4、如何使用ssl对流量进行加密

1.5、nginx添加ssl的支持

(1)完成 --with-http_ssl_module模块的增量添加

》将原有/usr/local/nginx/sbin/nginx进行备份

》拷贝nginx之前的配置信息

》在nginx的安装源码进行配置指定对应模块 ./configure --with-http_ssl_module

》通过make模板进行编译

》将objs下面的nginx移动到/usr/local/nginx/sbin下

》在源码目录下执行 make upgrade进行升级,这个可以实现不停机添加新模块的功能1.6、nginx的ssl相关指令

因为刚才我们介绍过该模块的指令都是通过ngx_http_ssl_module模块来解析的。

ssl:该指令用来在指定的服务器开启https,可以使用 listen 443 ssl,后面这种方式更通用些。

| 语法 | ssl on | off; |

| 默认值 | ssl off; |

| 位置 | http、server |

server{

listen 443 ssl;

}| 语法 | ssl_certificate file; |

| 默认值 | — |

| 位置 | http、server |

| 语法 | ssl_ceritificate_key file; |

| 默认值 | — |

| 位置 | http、server |

| 语法 | ssl_sesion_cache off|none|[builtin[:size]] [shared:name:size] |

| 默认值 | ssl_session_cache none; |

| 位置 | http、server |

| 语法 | ssl_session_timeout time; |

| 默认值 | ssl_session_timeout 5m; |

| 位置 | http、server |

| 语法 | ssl_ciphers ciphers; |

| 默认值 | ssl_ciphers high:!anull:!md5; |

| 位置 | http、server |

| 语法 | ssl_perfer_server_ciphers on|off; |

| 默认值 | ssl_perfer_server_ciphers off; |

| 位置 | http、server |

生成证书

先要确认当前系统是否有安装openssl

openssl version

安装下面的命令进行生成

mkdir /root/cert

cd /root/cert

openssl genrsa -des3 -out server.key 1024

openssl req -new -key server.key -out server.csr

cp server.key server.key.org

openssl rsa -in server.key.org -out server.key

openssl x509 -req -days 365 -in server.csr -signkey server.key -out server.crt开启ssl实例

server {

listen 443 ssl;

server_name localhost;

ssl_certificate server.cert;

ssl_certificate_key server.key;

ssl_session_cache shared:ssl:1m;

ssl_session_timeout 5m;

ssl_ciphers high:!anull:!md5;

ssl_prefer_server_ciphers on;

location / {

root html;

index index.html index.htm;

}

}(4)验证

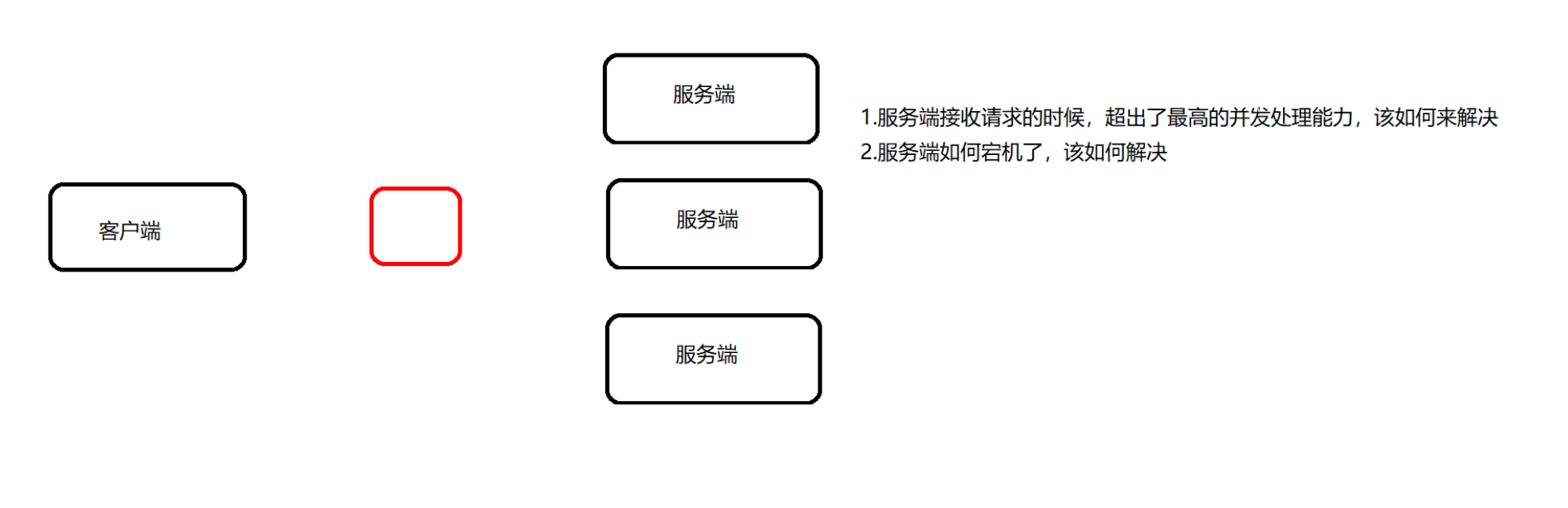

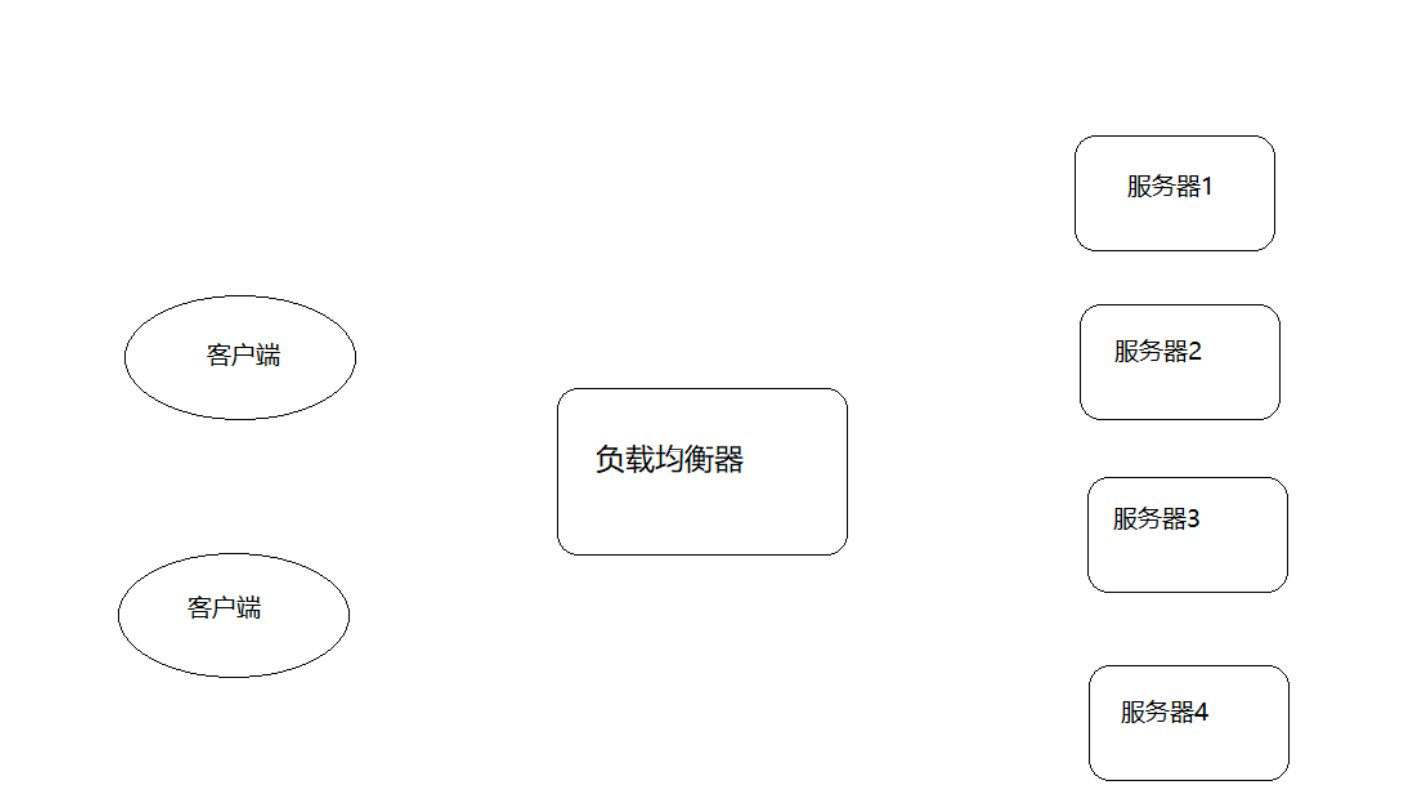

2、负载均衡概述

2.1、负载均衡的原理及处理流程

负载均衡的作用

2.2、负载均衡常用的处理方式

方式一:用户手动选择

方式二:dns轮询方式

1.可靠性低

2.负载均衡不均衡

方式三:四/七层负载均衡(重要)

介绍四/七层负载均衡之前,我们先了解一个概念,osi(open system interconnection),叫开放式系统互联模型,这个是由国际标准化组织iso指定的一个不基于具体机型、操作系统或公司的网络体系结构。该模型将网络通信的工作分为七层。

所谓四层负载均衡指的是osi七层模型中的传输层,主要是基于ip+port的负载均衡

实现四层负载均衡的方式:

硬件:f5 big-ip、radware等

软件:lvs、nginx、hayproxy等所谓的七层负载均衡指的是在应用层,主要是基于虚拟的url或主机ip的负载均衡

实现七层负载均衡的方式:

软件:nginx、hayproxy等四层和七层负载均衡的区别

四层负载均衡数据包是在底层就进行了分发,而七层负载均衡数据包则在最顶端进行分发,所以四层负载均衡的效率比七层负载均衡的要高。

四层负载均衡不识别域名,而七层负载均衡识别域名。处理四层和七层负载以为其实还有二层、三层负载均衡,二层是在数据链路层基于mac地址来实现负载均衡,三层是在网络层一般采用虚拟ip地址的方式实现负载均衡。

实际环境采用的模式

四层负载(lvs)+七层负载(nginx)

2.3、nginx七层负载均衡(重要)

2.4、nginx七层负载均衡的指令

upstream指令

| 语法 | upstream name {...} |

| 默认值 | — |

| 位置 | http |

server指令

| 语法 | server name [paramerters] |

| 默认值 | — |

| 位置 | upstream |

nginx七层负载均衡的实现流程

服务端设置

server {

listen 9001;

server_name localhost;

default_type text/html;

location /{

return 200 '<h1>192.168.200.146:9001</h1>';

}

}

server {

listen 9002;

server_name localhost;

default_type text/html;

location /{

return 200 '<h1>192.168.200.146:9002</h1>';

}

}

server {

listen 9003;

server_name localhost;

default_type text/html;

location /{

return 200 '<h1>192.168.200.146:9003</h1>';

}

}负载均衡器设置

upstream backend{

server 192.168.200.146:9091;

server 192.168.200.146:9092;

server 192.168.200.146:9093;

}

server {

listen 8083;

server_name localhost;

location /{

proxy_pass http://backend;

}

}2.4、负载均衡状态

代理服务器在负责均衡调度中的状态有以下几个:

| 状态 | 概述 |

| down | 当前的server暂时不参与负载均衡 |

| backup | 预留的备份服务器 |

| max_fails | 允许请求失败的次数 |

| fail_timeout | 经过max_fails失败后, 服务暂停时间 |

| max_conns | 限制最大的接收连接数 |

down

upstream backend{

server 192.168.200.146:9001 down;

server 192.168.200.146:9002

server 192.168.200.146:9003;

}

server {

listen 8083;

server_name localhost;

location /{

proxy_pass http://backend;

}

}该状态一般会对需要停机维护的服务器进行设置。

backup

upstream backend{

server 192.168.200.146:9001 down;

server 192.168.200.146:9002 backup;

server 192.168.200.146:9003;

}

server {

listen 8083;

server_name localhost;

location /{

proxy_pass http://backend;

}

}max_conns

max_fails和fail_timeout

upstream backend{

server 192.168.200.133:9001 down;

server 192.168.200.133:9002 backup;

server 192.168.200.133:9003 max_fails=3 fail_timeout=15;

}

server {

listen 8083;

server_name localhost;

location /{

proxy_pass http://backend;

}

}2.5、负载均衡策略(重要)

介绍完nginx负载均衡的相关指令后,我们已经能实现将用户的请求分发到不同的服务器上,那么除了采用默认的分配方式以外,我们还能采用什么样的负载算法?

nginx的upstream支持如下六种方式的分配算法,分别是:

| 算法名称 | 说明 |

| 轮询 | 默认方式 |

| weight | 权重方式 |

| ip_hash | 依据ip分配方式 |

| least_conn | 依据最少连接方式 |

| url_hash | 依据url分配方式 |

| fair | 依据响应时间方式 |

轮询(默认策略)

upstream backend{

server 192.168.200.146:9001 weight=1;

server 192.168.200.146:9002;

server 192.168.200.146:9003;

}

server {

listen 8083;

server_name localhost;

location /{

proxy_pass http://backend;

}

}weight加权[加权轮询]

upstream backend{

server 192.168.200.146:9001 weight=10;

server 192.168.200.146:9002 weight=5;

server 192.168.200.146:9003 weight=3;

}

server {

listen 8083;

server_name localhost;

location /{

proxy_pass http://backend;

}

}ip_hash

| 语法 | ip_hash; |

| 默认值 | — |

| 位置 | upstream |

upstream backend{

ip_hash;

server 192.168.200.146:9001;

server 192.168.200.146:9002;

server 192.168.200.146:9003;

}

server {

listen 8083;

server_name localhost;

location /{

proxy_pass http://backend;

}

}需要额外多说一点的是使用ip_hash指令无法保证后端服务器的负载均衡,可能导致有些后端服务器接收到的请求多,有些后端服务器接收的请求少,而且设置后端服务器权重等方法将不起作用。

least_conn

upstream backend{

least_conn;

server 192.168.200.146:9001;

server 192.168.200.146:9002;

server 192.168.200.146:9003;

}

server {

listen 8083;

server_name localhost;

location /{

proxy_pass http://backend;

}

}此负载均衡策略适合请求处理时间长短不一造成服务器过载的情况。

url_hash

upstream backend{

hash &request_uri;

server 192.168.200.146:9001;

server 192.168.200.146:9002;

server 192.168.200.146:9003;

}

server {

listen 8083;

server_name localhost;

location /{

proxy_pass http://backend;

}

}访问如下地址:

http://192.168.200.133:8083/a

http://192.168.200.133:8083/b

http://192.168.200.133:8083/cfair

upstream backend{

fair;

server 192.168.200.146:9001;

server 192.168.200.146:9002;

server 192.168.200.146:9003;

}

server {

listen 8083;

server_name localhost;

location /{

proxy_pass http://backend;

}

}但是如何直接使用会报错,因为fair属于第三方模块实现的负载均衡。需要添加nginx-upstream-fair,如何添加对应的模块:

- 下载nginx-upstream-fair模块

下载地址为:

https://github.com/gnosek/nginx-upstream-fair- 将下载的文件上传到服务器并进行解压缩

unzip nginx-upstream-fair-master.zip- 重命名资源

mv nginx-upstream-fair-master fair- 使用./configure命令将资源添加到nginx模块中

./configure --add-module=/root/fair- 编译

make

编译可能会出现如下错误,ngx_http_upstream_srv_conf_t结构中缺少default_port

解决方案:

在nginx的源码中 src/http/ngx_http_upstream.h,找到ngx_http_upstream_srv_conf_s,在模块中添加添加default_port属性

in_port_t default_port

然后再进行make.

- 更新nginx

6.1 将sbin目录下的nginx进行备份

mv /usr/local/nginx/sbin/nginx /usr/local/nginx/sbin/nginxold6.2 将安装目录下的objs中的nginx拷贝到sbin目录

cd objs

cp nginx /usr/local/nginx/sbin6.3 更新nginx

cd ../

make upgrade- 编译测试使用nginx

上面介绍了nginx常用的负载均衡的策略,有人说是5种,是把轮询和加权轮询归为一种,也有人说是6种。那么在咱们以后的开发中到底使用哪种,这个需要根据实际项目的应用场景来决定的。

2.6、负载均衡案例

案例一:对所有请求实现一般轮询规则的负载均衡

upstream backend{

server 192.168.200.146:9001;

server 192.168.200.146:9002;

server 192.168.200.146:9003;

}

server {

listen 8083;

server_name localhost;

location /{

proxy_pass http://backend;

}

}案例二:对所有请求实现加权轮询规则的负载均衡

upstream backend{

server 192.168.200.146:9001 weight=7;

server 192.168.200.146:9002 weight=5;

server 192.168.200.146:9003 weight=3;

}

server {

listen 8083;

server_name localhost;

location /{

proxy_pass http://backend;

}

}案例三:对特定资源实现负载均衡

upstream videobackend{

server 192.168.200.146:9001;

server 192.168.200.146:9002;

}

upstream filebackend{

server 192.168.200.146:9003;

server 192.168.200.146:9004;

}

server {

listen 8084;

server_name localhost;

location /video/ {

proxy_pass http://videobackend;

}

location /file/ {

proxy_pass http://filebackend;

}

}案例四:对不同域名实现负载均衡

upstream itcastbackend{

server 192.168.200.146:9001;

server 192.168.200.146:9002;

}

upstream itheimabackend{

server 192.168.200.146:9003;

server 192.168.200.146:9004;

}

server {

listen 8085;

server_name www.itcast.cn;

location / {

proxy_pass http://itcastbackend;

}

}

server {

listen 8086;

server_name www.itheima.cn;

location / {

proxy_pass http://itheimabackend;

}

}案例五:实现带有url重写的负载均衡

upstream backend{

server 192.168.200.146:9001;

server 192.168.200.146:9002;

server 192.168.200.146:9003;

}

server {

listen 80;

server_name localhost;

location /file/ {

rewrite ^(/file/.*) /server/$1 last;

}

location / {

proxy_pass http://backend;

}

}nginx四层负载均衡

添加stream模块的支持

nginx默认是没有编译这个模块的,需要使用到stream模块,那么需要在编译的时候加上--with-stream。

完成添加--with-stream的实现步骤:

》将原有/usr/local/nginx/sbin/nginx进行备份

》拷贝nginx之前的配置信息

》在nginx的安装源码进行配置指定对应模块 ./configure --with-stream

》通过make模板进行编译

》将objs下面的nginx移动到/usr/local/nginx/sbin下

》在源码目录下执行 make upgrade进行升级,这个可以实现不停机添加新模块的功能nginx四层负载均衡的指令

stream指令

| 语法 | stream { ... } |

| 默认值 | — |

| 位置 | main |

upstream指令

四层负载均衡的案例

需求分析

实现步骤

port 6379 #redis的端口

daemonize yes #后台启动redis7.将redis01复制一份为redis02

cd /usr/local/redis

cp -r redis01 redis028.将redis02文件文件夹中的redis.conf进行修改

port 6378 #redis的端口

daemonize yes #后台启动redis9.分别启动,即可获取两个redis.并查看

ps -ef | grep redis

使用nginx将请求分发到不同的redis服务器上。

(2)准备tomcat服务器.

1.上传tomcat的安装包,apache-tomcat-8.5.56.tar.gz

2.将安装包进行解压缩

tar -zxf apache-tomcat-8.5.56.tar.gz

3.进入tomcat的bin目录

cd apache-tomcat-8.5.56/bin

./startupnginx.conf配置

stream {

upstream redisbackend {

server 192.168.200.146:6379;

server 192.168.200.146:6378;

}

upstream tomcatbackend {

server 192.168.200.146:8080;

}

server {

listen 81;

proxy_pass redisbackend;

}

server {

listen 82;

proxy_pass tomcatbackend;

}

}访问测试。

微信扫一扫

微信扫一扫

您想发表意见!!点此发布评论

发表评论